Google: Inhalte, die auf mehreren Seiten verwendet werden, müssen nicht blockiert werden

Das Blockieren von Inhalten für das Indexieren, die auf mehreren Unterseiten verwendet werden, ist laut Google nicht nötig. Es gäbe ohnehin keine Möglichkeit dafür.

Das Blockieren von Inhalten für das Indexieren, die auf mehreren Unterseiten verwendet werden, ist laut Google nicht nötig. Es gäbe ohnehin keine Möglichkeit dafür.

Auf den meisten Websites gibt es Inhalte, die auf mehreren oder sogar auf allen Unterseiten vorkommen. Das kann zum Beispiel ein Text im Footer sein oder eine Kurzbeschreibung des Autors unterhalb der Artikel.

Hier stellt sich die Frage, ob durch solche mehrfach verwendeten Inhalte Duplicate Content in den Suchergebnissen von Google entstehen kann und ob es nicht besser wäre, solche Inhalte von der Indexierung auszuschließen.

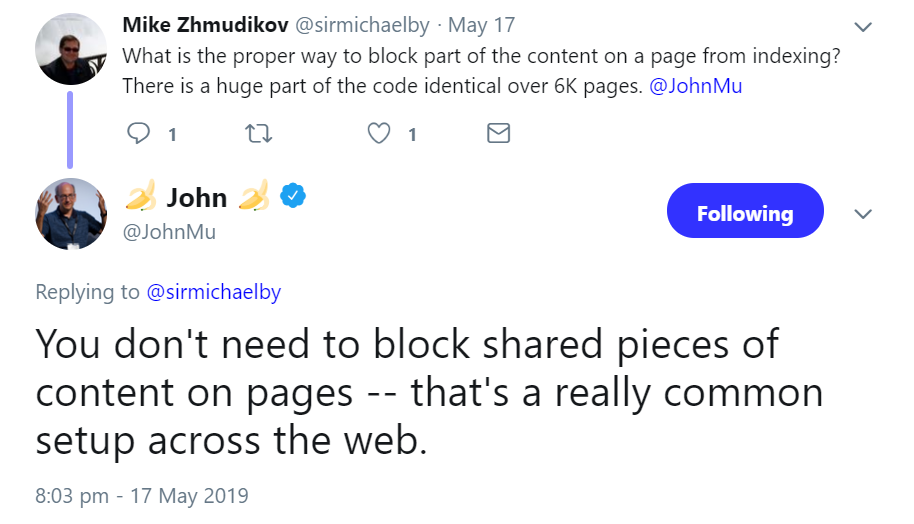

Das ist laut Google aber nicht nötig. Johannes Müller erklärte per Twitter, man müsse solche auf mehreren Seiten verwendete Inhalte nicht blockieren.

Eine Gefahr durch Duplicate Content in den Suchergebnissen besteht demnach wohl nicht.

Es gäbe auch keine Möglichkeit, Google mitzuteilen, dass bestimmte Bereiche einer Seite nicht beim Indexieren berücksichigt werden sollen. Nur komplette Seiten oder Dateien können per Meta Robots Tag oder per X Robots Tag im HTTP-Header vom Indexieren augeschlossen werden. Ähnlich sieht es beim Crawlen aus: In der robots.txt können Direktiven nur für Seiten, Dateien oder Pfade gesetzt werden, nicht aber für bestimmte Seitenbereiche.

Titelbild: Copyright BillionPhotos.com

SEO-Newsletter bestellen

Verwandte Beiträge

Neuer Hinweis von Google: Für Bilder auf einer Website immer dieselbe URL verwenden