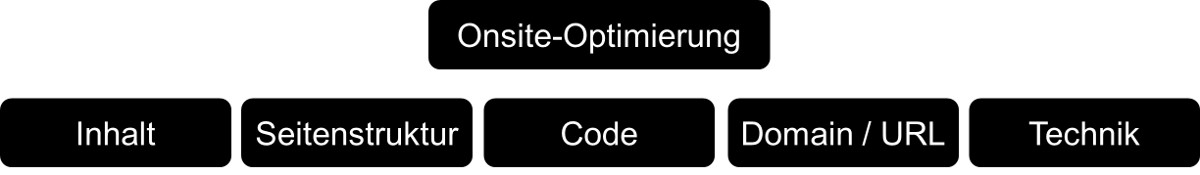

Onsite-Optimierung

Bevor man sich Gedanken über die Verlinkung der Homepage und deren Ranking in den Suchergebnissen macht, sollte man den Webauftritt erst einmal attraktiv für die Nutzer machen. Denn ein wichtiger Grundsatz bei der Suchmaschinenoptimierung lautet: Was gut für den Nutzer ist, ist auch gut für das Ranking in Suchmaschinen. Darum geht es in der Onsite-Optimierung.

Bevor man sich Gedanken über die Verlinkung der Homepage und deren Ranking in den Suchergebnissen macht, sollte man den Webauftritt erst einmal attraktiv für die Nutzer machen. Denn ein wichtiger Grundsatz bei der Suchmaschinenoptimierung lautet: Was gut für den Nutzer ist, ist auch gut für das Ranking in Suchmaschinen. Darum geht es in der Onsite-Optimierung.

Die Onsite-Optimierung bezieht sich auf alle Maßnahmen, die auf der eigenen Homepage bzw. auf dem eigenen Server stattfinden. Dazu zählen den Blöcken Inhalt, Seitenstruktur, Quellcode und Domain auch die technische Optimierung (technische SEO).

Unterschied zwischen Onsite-Optimierung und Onpage-Optimierung

Die Begriffe "Onsite-Optimierung" und "Onpage-Optimierung" werden oft synonym verwendet. Dabei handelt es sich um zwei getrennte Bereiche. Während die Onpage-Optimierung nur die Webseite und die auf ihr verwendeten Inhalte sowie die Struktur und den Code zum Gegenstand hat, greift der Begriff der Onsite-Optimierung weiter und bezieht auch die Infrastruktur, den Server, die mögliche Anbindung an Content Delivery Networks etc. mit ein. Aufgrund des erweiterten Geltungsbereichs ist in diesem Beitrag stets von Onsite-Optimierung die Rede.

Inhalt

Sie müssen sich als erstes überlegen, was für die Nutzer interessant ist und wodurch sich die eigene Homepage von anderen Angeboten abheben kann. Im Prinzip ist es ganz einfach: Es sind die Inhalte, die zählen. Dinge, die dem Nutzer weiterhelfen, Dinge, die möglichst präzise zum Gesuchten passen, und Dinge, die anderswo so nicht verfügbar sind.

Ein schlechtes Beispiel ist eine Seite, die lediglich aus zusammenkopierten Inhalten anderer Angebote im Web besteht - zumal das auch rechtlich nicht unbedenklich ist. Gut ist es dagegen, selbst recherchierte und aufbereitete Informationen anzubieten, die zudem möglichst aktuell sein sollten. Selbstverständlich sollten auch Rechtschreibung und Grammatik der Texte fehlerfrei sein. Rechtschreib- oder Kommafehler verleihen dem eigenen Auftritt leicht etwas Dilettantisches und Unseriöses.

Zur Optimierung der Inhalte gehört es auch, sich Gedanken über die passenden Keywords zu machen, unter denen man gefunden werden möchte. Denn nur dann, wenn man in den Suchmaschinen bei den richtigen Begriffen auftaucht, werden Besucher auf die Homepage kommen. Dies zu erreichen erfordert meist einiges an Erfahrung und häufigeres Nachjustieren, bis es richtig passt.

Vier Begriffe beschreiben, worauf es beim Inhalt ankommt: Information, Rechtschreibung / Grammatik und Keywords. Der Inhalt ist das Wichtigste auf einer Website. Der Inhalt ist der Grund, warum sich Nutzer dafür interessieren - oder kennen Sie jemanden, der eine Homepage nur wegen einer aufwändigen Flash-Animation besucht? Ein gutes Ranking in den Suchmaschinen ist auf Dauer ohne guten und besonderen Inhalt nicht erreichbar. Hier sollte also das Hauptaugenmerk bei der SEO liegen. Dazu muss man sich zunächst überlegen, welchen Mehrwert man dem Nutzer bieten kann. Das können exklusive Informationen sein wie zum Beispiel aktuelle Nachrichten, gratis angebotene Software oder unterhaltsame Onlinespiele. Das bringt Publikum und kann den einen oder anderen Link bringen.

Sechs Eigenschaften für interessanten Inhalt

Es gibt laut Fachliteratur sechs Attribute für interessanten Inhalt: Er sollte kostenlos, aktuell, künstlerisch, außergewöhnlich und herunterladbar sein und mit gesellschaftlichen Normen brechen (vgl. Erlhofer, S.: Suchmaschinen-Optimierung für Webentwickler – Grundlagen, Ranking optimieren, Tipps und Tricks, 2. aktual. und erw. Auflage, Bonn, Seiten 115-144, 169-288, 2006). Selbst wenn nicht all diese Attribute erfüllt werden, so stellen diese doch eine Richtschnur dar, an der man sich orientieren kann. Auffallen lautet die Devise.

Neben dem Informationsgehalt ist auch die korrekte Präsentation des Inhalts zu beachten. Rechtschreib- und Grammatikfehler machen einen unseriösen Eindruck und verschlechtern zudem das Ranking in den Suchmaschinen, wenn die Nutzer nach den richtig geschriebenen Begriffen suchen. Genauso wie die geschäftliche Korrespondenz muss auch der Internetauftritt einwandfrei sein.

Unter welchen Begriffen (Keywords) man gefunden werden möchte, ist eine weitere und entscheidende Frage. Dabei ist zu beachten, dass die Optimierung einer Seite nur für eine begrenzte Anzahl von Begriffen sinnvoll ist - normalerweise zwischen drei und fünf. Der Grund dafür liegt auf der Hand: Je mehr Begriffe gewählt werden, desto weniger können diese auf der Seite repräsentiert sein - und damit sinkt automatisch die Relevanz. Es gibt zwar nach wie vor Seitenbetreiber, die durch große Listen von Begriffen die Relevanz einzelner Seiten auf möglichst breiter Basis erhöhen möchten, doch zum einen bringt das aber dem Nutzer nichts, der die Seite besucht - er wird wohl nicht wiederkommen - und zum anderen merken die meisten Suchmaschinen inzwischen, wenn man ihnen etwas vormacht.

Informationen

Schaffen Sie also möglichst interessante Inhalte, die dem Nutzer einen Mehrwert bieten. Liefern Sie Erkenntnisse, die man anderswo nicht bekommt. Wie wäre es beispielsweise mit einem regelmäßig aktualisierten Nachrichten-Blog? Ist Ihre Seite die erste, die einen Beitrag zu einem bestimmten saisonalen Ereignis veröffentlicht? Vielleicht gibt es wissenschaftliche Artikel, die hier veröffentlicht werden können? Gibt es interessante Produktinnovationen, Ratgeber, Expertentipps? Generell gilt: Was für den Nutzer gut ist, ist auch für das Ranking in Suchmaschinen gut. Interessante Texte (zum Beispiel wissenschaftliche Arbeiten) können als PDF zum Download angeboten werden. PDF-Dokumente sollten vorher optimiert und die richtigen Meta-Informationen gesetzt werden. Das kann mit Hilfe eines PDF-Generators wie zum Beispiel dem Acrobat von Adobe erledigt werden.

Aktualität können Sie zum Beispiel durch das Einrichten eines Forums erreichen, in dem sich die Nutzer zu verschiedenen Themen austauschen. Die Erfahrung zeigt, dass solche Foren von den Suchmaschinen recht hoch bewertet werden. Was auf jeden Fall vermieden werden muss, ist das bloße Kopieren von Inhalten anderer Seiten. Nicht nur, dass so etwas gegen das Urhebberrecht verstößt; doppelte Inhalte (Duplicate Content) werden in Suchmaschinen schnell sichtbar und wirken sich negativ auf das Ranking aus. Wenn ein identischer Text in zehn verschiedenen Suchtreffern enthalten ist, schmälert das natürlich auch die Wahrscheinlichkeit, dass sich Besucher ausgerechnet auf Ihre Seite verirren.

Apropos doppelte Inhalte: Sie sollten diese natürlich auch innerhalb ihrer eigenen Seiten vermeiden. Ein häufiger Fehler ist beispielsweise, dass ein und derselbe Inhalt in mehreren Versionen verfügbar ist - etwa in normaler Darstellung und als Druckansicht. In diesem Fall müssen Sie darauf achten, dass von den Suchmaschinen nur eine Seite in den Index aufgenommen wird. Das lässt sich zum Beispiel durch das Definieren von Canonical-Links ereichen. Andernfalls büßen Sie dadurch an Relevanz ein, weil sich diese auf mehere Seiten verteilt.

Nutzen Sie bei Ihren Texten das Prinzip der invertierten Pyramide. Das bedeutet, dass die wichtigsten Informationen oben stehen und die Bedeutung nach unten hin abnimmt. Zum einen kommen Sie damit dem Nutzerverhalten entgegen (die Aufmerksamkeit lässt mit zunehmender Lesedauer nach); zum anderen führt dies mit großer Wahrscheinlichkeit zu einem besseren Ranking in den Suchmaschinen, da auch hier oben stehende Begriffe höher gewichtet werden.

Rechtschreibung und Grammatik

Es ist erschreckend zu beobachten, wie gering die Anzahl der im Netz veröffentlichten Texte ohne Fehler ist. Das betrifft aber nicht nur Seiten im Internet, sondern auch Artikel in Zeitungen und Zeitschriften, ganz zu schweigen von E-Mails. Korrekte Rechtschreibung und Grammatik sind das Aushängeschild eines gepflegten Webauftritts. Insbesondere bei gewerblichen Angeboten, die auf Geschäftskunden ausgerichtet sind, ist Fehlerfreiheit ein Muss. Man erkennt daran die Seriosität einer Homepage. Hinzu kommt, dass Suchmaschinen (insbesondere Google) auch menschliche Qualitätstester beschäftigen, die stichprobenartig bestimmte Webseiten besuchen. Das Urteil eines solchen Testers kann Auswirkungen auf das Ranking einer Seite in den Suchergebnissen haben.

Beherzigen Sie das Vier-Augen-Prinzip und lassen Sie eine zusätzliche, unabhängige Prüfung vornehmen. Hier gilt: je mehr Tests, desto besser. Gerade durch die Rechtschreibreform sind viele Homepagebesitzer verunsichert. Nutzen Sie im Zweifelsfall eine aktuelle Ausgabe des Dudens.

Keywords

Überlegen Sie bereits während der Planung Ihrer Homepage, unter welchen Begriffen Sie in den Suchmaschinen gefunden werden möchten. Wie oben bereits erwähnt, sollten Sie sich auf die drei bis fünf wichtigsten Begriffe pro Seite beschränken. Es gibt verschiedene Möglichkeiten, wie Sie passende Keywords für Ihre Homepage finden können:

- Brainstorming: Bitten Sie Freunde, mit Ihnen gemeinsam Vorschläge sammeln. Anschließend wählen Sie die besten Ideen aus.

- Konkurrenzanalyse: Sie sind wahrscheinlich nicht der einzige, der eine Homepage zu Ihrem Thema anbietet. Sehen Sie sich den Quelltext Ihrer Konkurrenten an. Viele schreiben nach wie vor ihre Keywords in die Meta-Tags ihrer Homepage. Das ist oft sehr aufschlussreich.

- Online-Werkzeuge: Hier gibt es einige sehr gute Hilfsmittel, die Sie bei der Keywordsuche unterstützen. Ein gutes Beispiel ist die Seite ranking-check.de. Sie geben hier einen Suchbegriff ein und erhalten dazu passende Keywords ausgeliefert. Ebenfalls sehr gute Ergebnisse liefert das Google Adwords-Tool (Keyword-Planer). Und wenn Sie erkennen möchten, welche Keywords in Zukunft populär sein werden, empfiehlt sich Google Trends.

Sie können auch zusammengesetzte Begriffe verwenden, wenn es die Konkurrenzsituation erfordert. Beispiel: Sie möchten Ihre Homepage zum Thema Suchmaschinenoptimierung veröffentlichen und unter dem Begriff "SEO" gefunden werden. Google.de liefert Ihnen zu diesem Begriff 530.000.000 (530 Millionen) Suchtreffer. Da wird es schwierig, unter die ersten Zehn zu kommen. Daher sollten Sie sich überlegen, wie sich der Begriff erweitern lässt, so dass er zu Ihrem Angebot passt und ihnen trotzdem die gewünschten Ergebnisse in den Suchmaschinen liefert. Angenommen, Ihr Angebot ist regional begrenzt, und Sie bieten Ihre Dienste vor allem in Karlsruhe an. Dann wäre für Sie der Begriff "SEO Karlsruhe" geeignet. Und siehe da: Bei der Suche nach "SEO Karlsruhe" spuckt Google "nur" noch 441.000 Treffer aus. Ein wenig Optimierung, und die Chancen auf einen guten Platz in der Trefferliste steigen. Hier sind noch einige Tipps, die Sie bei der Wahl Ihrer Keywords bachten sollten:

- Binden Sie die gewünschten Begriffe nicht nur in der Stammform ein. Beispiel: „Als führender Anbieter von Krediten…“, „Falls Sie einen Kredit benötigen,…“

- Vermeiden Sie Fachbegriffe, die keiner kennt. Versetzen Sie sich in die Position des Kunden und überlegen Sie, wonach er suchen würde.

- Versuchen Sie, auch falsch geschriebene Begriffe unterzubringen. Oftmals führt das zu zusätzlichen Suchtreffern. Beispiel: „…Girokonto (oftmals auch Giro Konto geschrieben)…“

- Überlegen Sie, ob das gewünschte Keyword eher im Singular oder im Plural gesucht wird. Natürlich kann hier auch bewusst auf die weniger gesuchte Form gesetzt werden, da weniger Konkurrenz besteht.

- Synonyme im Text erhöhen die Relevanz der Seite bei der Bewertung durch die Suchmaschine.

- Vermeiden Sie „Keyword-Stuffing“ – unnötige Wiederholungen der immer gleichen Begriffe führen unter Umständen sogar zur Abwertung in den Suchmaschinen.

Keyworddichte (Keyword Density) und Keywordhäufigkeit

Wenn Sie der Meinung sind, dass ein direkter Zusammenhang zwischen der Häufigkeit eines Keywords auf Ihren Seiten und der damit verbundenen Relevanz in Suchmaschinen besteht, dann liegen Sie nur bedingt richtig. Ob es überhaupt einen kausalen Zusammenhang zwischen der Häufigkeit eines Keywords und der durch Suchmaschinen beigemessenen Relevanz gibt, ist fraglich, und ab einer bestimmten Grenze wirkt sich eine zunehmende Häufigkeit mit Sicherheit negativ aus. Unnötige Wiederholungen von Keywords werden als "Keyword Stuffing" bezeichnet. Suchmaschinen erkennen das und bestrafen mit Abwertung. Versuchen Sie, Ihre Keywords gezielt und sinnvoll in Ihren Texten unterzubringen. Vor allem in Überschriften bietet sich das an; auch Aufzählungen (sortierte oder unsortierte Listen) sind ein guter Ort für Keywords. Bedenken Sie auch, dass die Relevanzbewertung innerhalb von Texten von oben nach unten abnimmt. Keywords im oberen Textbereich wirken also besser als im unteren. Man spricht hier auch vom Prinzip der invertierten Pyramide.

Die Keyworddichte einer Seite gibt den prozentualen Anteil eines Keywords am Gesamttext an. Wenn Sie zum Beispiel einen Text mit 200 Wörtern verfasst haben, in dem fünfmal der Begriff "SEO" vorkommt, so haben Sie für diesen Begriff eine Keyworddichte von 2,5 Prozent. Welcher Wert hier optimal ist, lässt sich nicht ohne Weiteres sagen, da hier die Angaben in der Literatur auseinandergehen. Die Keyworddichte einer Seite lässt sich übrigens einfach mit Onlinewerkzeugen wie zum Beispiel Quirk SearchStatus überprüfen.

Keywords und Synonyme

Suchmaschinen bewerten nicht nur die exakt erwähnten Keywords, sondern lassen auch Synonyme mit in die Bewertung einfließen. Ein gut verfasster und im Hinblick auf Suchmaschinen optimierter Text sollte also möglichst auch eine Vielzahl von Begriffen enthalten, die inhaltlich die selbe Bedeutung wie das gewünschte Keyword haben. Aber auch verwandte Begriffe aus dem thematischen Umfeld des jeweiligen Keywords erhöhen die Relevanz. Wenn Texte nach diesen Kriterien verändert werden, spricht man auch von Latent Semantischer Optimierung (LSO). Es gibt zahlreiche kostenlose Werkzeuge im Internet, mit denen Sie Synonyme oder verwandte Begriffe finden können. Ein Beispiel ist Wikimindmap.org.

Seitenstruktur

Gute und interessante Inhalte alleine reichen aber nicht aus. Auch die Seitenstruktur und die Präsentation der Inhalte spielen eine wichtige Rolle, wenn es um gute Rankings in den Suchmaschinen geht. Das bezieht sich aber eben nicht auf eine auf möglichst bunte und multimediale Aufbereitung der Inhalte: Der Nutzer sollte auch nicht von Textwüsten und undurchschaubaren Navigationselementen erschlagen werden. Das Ziel muss es immer sein, dem Nutzer die gewünschten Informationen möglichst einfach zugänglich zu machen. Zu einer guten Seitenstruktur im SEO-Sinn gehört auch die gezielte Verteilung interner Links, damit sich die Linkpower möglichst gut auf alle Unterseiten verteilen kann (Stichwort PageRank-Sculpting). Wichtig sind auch der gezielte und dosierte Einsatz von Bildern und Grafiken, die logische Gliederung von Texten und das Vermeiden von doppelten Inhalten. Nicht zu vergessen ist die überlegte Wahl der passenden URL und der zugehörigen Unterseiten.

Die Seitenstruktur betrifft den Aufbau der einzelnen Seiten der Homepage und deren Gliederung. Dazu gehören eine übersichtliche Unterteilung der Texte, die Navigation zwischen den einzelnen Seiten und die übersichtliche Darstellung der Homepage in Form von sogenannten Sitemaps. Eine aufgeräumte Seitenstruktur verfolgt das Ziel, es dem Nutzer und den Suchmaschinen so einfach wie möglich zu machen, sich auf der Homepage zurecht zu finden. Dazu gibt es einige Werkzeuge und Grundregeln, die beachtet werden sollten. Im Folgenden wird beschrieben, worauf Sie bei der Navigation und der Textgliederung achten müssen. Ebenso finden Sie einige Anmerkungen zur Verwendung von Sitemaps. Auch die Themen Frames, Tabellen und Cookies werden kurz beschrieben. Mit diesen Informationen sollten Sie über das Grundwissen verfügen, eine übersichtliche und und aufgeräumte Homepage gestalten zu können.

Navigation

Eine übersichtliche Navigation erleichtert es, alle wichtigen Seiten und Inhalte schnell zu finden und zwischen den einzelnen Seiten der Homepage zu wechseln. Nutzer haben es somit leichter, sich zurecht zu finden, und Suchmaschinen haben es leichter, die Seiten in ihren Index aufzunehmen.

Für die inhaltliche Struktur der Homepage gilt: Eine Gliederungstiefe von maximal drei Ebenen ist zu empfehlen. Beispiel: Ebene 1 (allgemein): Haustiere - Ebene 2 (spezieller): Katzen - Ebene 3 (Detailebene): Perserkatzen. Zusätzliche Hierarchieebenen sind nicht zu empfehlen. Falls diese doch nötig sind, sollte die Navigation durch die Ebenen logisch und für den Nutzer intuitiv nachvollziehbar sein. Damit sich die Nutzer jederzeit orientieren und schnell zwischen den Hierarchieebenen wechseln können, bietet sich eine sogenannte Brotkrumen-Navigation an, die auch auf dieser Homepage verwendet wird. Die Nutzer können bei Bedarf leicht zur Startseite zurückkehren. Viele Content-Management-Systeme bieten diese Art der Navigation optional an. Bei manchen Systemen lässt sie sich per Plugin (Erweiterung, die zusätzlich installiert werden muss) nachträglich einbinden.

Die Hauptnavigation sollte auf der linken Seite der Homepage sein, weil die Nutzer daran gewöhnt sind. Experimente mit davon abweichenden Platzierungen erweisen sich stets ungünstig für die Nutzbarkeit.

Für die Verlinkung zwischen den einzelnen Seiten sollten Textlinks anstelle von Grafiken verwendet werden. Wenn grafische Links verwendet werden, müssen diese mit aussagekräftigen Ankertexten versehen werden. Name und Titel der Textlinks sollten sprechend sein und können gerne die gewünschten Keywords enthalten, wenn das dem Kontext des umgebenden Textes entspricht (Beispiel: <a href=„http://meineseite.de/link.htm" title=„Linkname“>Linktext). Dabei muss aber auf Natürlichkeit geachtet werden.

Prüfen Sie regelmäßig, ob die Links auf Ihren Seiten noch funktionieren. Oft ändern sich bei der Aktualisierung der Homepage auch die Links, so dass die alten Verweise ins Leere führen. Das ist dann weder für die Nutzer noch die Suchmaschinen schön. Zur Überprüfung auf fehlerhafte Links (auch Broken Links genannt) gibt es eine Menge kostenloser Werkzeuge im Internet. Zwei Beispiele:

- Der Link Checker von W3C --> Sehr übersichtliche Aufbereitung der analysierten Links

- Broken Link Checker von Submit Express --> Weniger detailliert, aber für eine erste Analyse gut.

HTML-Sitemap und XML-Sitemap

Es gibt zwei praktische Werkzeuge, um einen Überblick über den Inhalt einer Website anzubieten. Diese haben einen ähnlichen Namen und werden daher gerne verwechselt: HTML-Sitemap und XML-Sitemap. Dabei handelt es sich jedoch um unterschiedliche Begriffe mit unterschiedlichen Zielgruppen:

Die HTML-Sitemap wird als eigene Seite im Webauftritt eingebunden und zeigt dem Nutzer auf einen Blick ein Verzeichnis aller Seiten der Homepage. Von dort können die Seiten direkt aufgerufen werden. Zu empfehlen ist ein alphabetischer Index.

Die XML-Sitemap dient den Suchmaschinen als Orientierung. Sie enthält die URLs der einzelnen Seiten und optional jeweils Angaben zum Zeitpunkt der letzten Änderung, zur Änderungshäufigkeit und zur Priorität. Die Suchmaschinen werden durch die XML-Sitemap bei der Indexierung der Seiten unterstützt. Bei Google kann man zum Beispiel eine zuvor generierte Sitemap hochladen. Das funktioniert mittels der frei verfügbaren Google Search Console. Ob dies einen positiven Einfluss auf das Ranking in der Suchmaschine hat, ist nicht sicher. Schaden kann es jedoch nicht. Auch zum Erstellen von XML-Sitemaps gibt es kostenlose Werkzeuge im Netz, zum Beispiel XML-Sitemaps.com --> Kostenlos bis zu einer Anzahl von 500 Seiten. Hier können sowohl XML- als auch HTML-Sitemaps erstellt werden.

Weisen Sie in Ihrer robots.txt-Datei auf Ihre XML-Sitemap hin. Dazu schreiben Sie einfach an eine beliebige Stelle der Datei eine Zeile nach dem Muster Sitemap: http://www.meine-website.de/sitemap.xml.

Frames und Tabellen

Frames teilen die Seiten in verschiedene Bereiche auf, die individuell gestaltet werden können. Der Nachteil von Frames ist aber, dass Suchmaschinen wie Google sie wie einzelne Seiten bewerten. Dadurch verteilt sich die Relevanz der Seite bzw. deren PageRank auf mehrere Häppchen, was zu schlechteren Suchergebnissen führt. Grundsätzlich sollte daher auf Frames verzichtet werden. Früher wurden Frames gerne dazu verwendet, die Ergebnisse der Suchmaschinen zu manipulieren. Dazu wurde einfach der sogenannte No-Frames-Bereich (das ist der Bereich, der von Browsern angezeigt wird, die keine Frames unterstützen) mit Keywords vollgestopft. Da so gut wie alle Browser Frames unterstützen, bekamen die meisten Nutzer die normale Seite zu sehen, und nur die Suchmaschinen wurden mit den Keywords konfrontiert. Heute funktioniert diese Methode nicht mehr.

Tabellen wiederum haben einen anderen Nachteil: Sie können dazu führen, dass der eigentliche Inhalt einer Seite zu spät ausgelesen wird, weil im Quelltext der Seite eine andere Spalte (welche zum Beispiel den Code für die Navigation enthält) weiter vorne steht. Dies kann zwar umgangen werden, ist jedoch trotzdem unschön.

Daher beachten: Lassen Sie Frames komplett weg und setzen Sie Tabellen nur dort ein, wo es unbedingt nötig ist. Tabellen können durch Tricks zusätzlich für Suchmaschinen optimiert werden.

Textgliederung

Machen Sie es Ihren Besuchern so einfach und so angenehm wie möglich, Ihre Texte zu lesen. Vermeiden Sie lange Textwüsten ohne sichtbare Ankerpunkte. Eine logische und übersichtliche Gliederung in sinnvolle Abschnitte trägt einen großen Teil dazu bei. Verwenden Sie für Abschnitte und Unterabschnitte passende Überschriften. Dafür können in HTML die verschieden Größen der Überschriften verwendet werden (am besten <h1> bis <h4>). Auf diese Weise erreichen Sie, dass auch lange Texte bis zum Ende gelesen werden. Trotzdem: Packen Sie nicht all zu viel Text auf eine Seite; besser ist es, diesen auf mehrere Seiten verteilen. Hier gilt die Richtschnur "eine DIN-A4-Seite". Bringen Sie Ihre Keywords oder Synonyme davon möglichst in den Überschriften unter - natürlich nur dort, wo es einen Sinn ergibt. Keywords in Überschriften werden von den Suchmaschinen höher gewichtet als Keywords irgendwo anders im Text.

Ein Wort zu Cookies

Cookies sind kleine Dateien, die vom Server auf dem lokalen Rechner der Nutzer abgelegt werden. Anhand der darin gespeicherten Informationen kann sich der Server später wieder an einen Besucher erinnern und ihm ein Profil zuweisen. Vermeiden Sie aber möglichst Cookie-Zwang für die Besucher Ihrer Homepage. Suchmaschinen können nämlich mit Cookies nichts anfangen und werden im Zweifelsfall die betreffenden Seiten nicht indexieren. Setzen Sie Cookies nur dann ein, wenn sie wirklich unverzichtbar sind - das ist beispielsweise bei manchen Shop-Systemen der Fall.

Quellcode

Neben der Optimierung des Inhalts und der Seitenstruktur stellt die Überabeitung des Quellcodes den dritten Bestandteil der Onsite-Optimierung dar. Hier gibt es sehr viele Möglichkeiten, das Ranking in Suchmaschinen positiv zu beeinflussen. Die populärsten Maßnahmen betreffen das Anpassen von Titel und Beschreibungstext der Seiten, das Strukturieren des Seitentextes mit bestimmten HTML-Tags oder auch das Optimieren der Meta-Tags. Nicht zu vergessen ist eine Prüfung auf Validität bzw. fehlerloses HTML.

Ganz aktuell ist das Thema strukturierte Daten: Das sind Zusatzinformationen im Quellcode, die es den Suchmaschinen erleichtern, Elemente von Webseiten inhaltlich (man spricht auch von Semantik) zuzuordnen. Für verschiedene Branchen und Typen von Webseiten gibt es verschiedene Kategorien strukturierter Daten, die auf schema.org dokumentiert sind.

Wenn man testen möchte, ob die strukturierten Daten für die eigene Seite richtig gesetzt sind, kann man das Structured Data Testing Tool von Google verwenden.

In erster Linie weniger für die Nutzer sichtbar, doch für das Ranking in Suchmaschinen von Bedeutung ist der Quellcode einer Homepage. Man kann zwischen allgemeiner Codequalität und -valididät und bestimmten, speziell auf SEO-Zwecke ausgerichteten Aspekten unterscheiden. Zu Letzteren zählen zum Beispiel die Meta-Tags im Kopfbereich des Quellcodes oder die genannten strukturierten Daten.

Valides HTML

Für eine saubere Darstellung der Seiten im Browser und als Zeichen für eine hohe Qualität Ihrer Homepage sollten Sie auf valides HTML achten. Das bedeutet, dass die Struktur Ihres Quellcodes gemäß den Vorgaben des offiziellen HTML-Standards umgesetzt ist. Dazu zählt beispielsweise, dass jedes geöffnete Tag (also die Anweisungen in spitzen Klammern wie <br>) auch wieder geschlossen wird. Eine Suchmaschine wie Google lässt die Codequalität ebenfalls in ihre Bewertung einfließen - zumindest vielleicht. Genau kann das niemand sagen, weil die zugehörigen Algorithmen nicht veröffentlicht werden.

Für die Überprüfung des Quellcodes gibt es einige nützliche und kostenlose Werkzeuge im Internet, zum Beispiel der Validator von W3C. Keine Angst, wenn Sie Fehler angezeigt bekommen. Die wenigsten Seiten im Internet sind völlig fehlerfrei (das betrifft auch diese hier). Es geht nur darum, die Anzahl der Fehler möglichst gering zu halten. Fallls Sie also Fehler finden, versuchen Sie, diese selbst zu beheben, oder wenden Sie sich an Ihre Internet-Agentur.

Seitentitel

Was auf jeden Fall Auswirkungen auf das Ranking in Suchmaschinen hat, sind die Seitentitel Ihrer Homepage. Der Seitentitel wird im oberen Bereich des Browserfensters angezeigt. Jede einzelne Seite Ihres Webauftritts sollte einen individuellen Seitentitel haben. Dieser wird jeweils durch das <title>-Tag im Quelltext gekennzeichnet. Bei den gängigen Content-Management-Systemen können Sie den Titel bequem per Benutzeroberfläche festlegen.

Individuelle und aussagekräftige Seitentitel erhöhen die Chance auf passende und gut platzierte Suchtreffer in Suchmaschinen, da diese die Seitentitel mit relativ hohem Gewicht in die Relevanzbewertung einfließen lassen. Die Titel sollten nicht zu lange sein. Acht bis zehn Worte sind die Obergrenze. Bitte verwenden Sie keine bloße Aneinanderreihung von Keywords - das wird von Suchmaschinen erkannt und führt zur Abwertung.

Die Optimierung der Seitentitel ist ein entscheidender Faktor nicht nur für das Ranking, sondern auch für die Klickrate in den Suchergebnissen. Daher sollte darauf größte Sorgfalt verwendet werden.

Meta-Tags

Jede Seite kann im Quelltext in ihrem Kopfbereich (Header) oberhalb des eigentlichen Seiteninhalts (Body) beschreibende Informationen über die Seite enthalten. Der Header ist der obere Bereich im Quelltext einer Seite, der sich zwischen dem einleitenden <head>- und dem abschließenden </head>-Element befindet.

Das wichtigste Meta-Tag ist „description“, das die Beschreibung für die betreffende Seite enthält. Jede Seite muss eine individuelle Beschreibung haben. Die Beschreibung sollte nicht zu lange sein, am besten nicht mehr als zwei bis drei Sätze. Auch hier gilt: keine bloße Aneinanderreihung von Keywords, sondern zusammenhängende Sätze. Achtung: Die Beschreibung wird möglicherweise in der Suchmaschine als Teil des Suchtreffers angezeigt. Manchmal erstellen die Suchmaschinen aber auch selbst einen Textschnipsel, den sie auf der Suchergebnisseite anzeigen. Die Description wird von Google nicht für das Ranking genutzt, aber sie ist ein wichtiger Faktor, wenn es um die Klickrate der Nutzer geht!

Ein früher gerne verwendetes Meta-Tag ist "keywords". Wie der Name vermuten lässt, können hier die Schlüsselbegriffe eingetragen werden, unter denen die Seite gefunden werden soll. Weil dieses Meta-Tag in der Vergangenheit zu Manipulationen der Suchtreffer verwendet wurde, werten es die Suchmaschinen nicht mehr aus. Allerdings können die Meta-Keywords noch andere Aufgaben übernehmen: So verwenden zum Beispiel manche Content Management Systeme diese Meta-Tags, um verwandte Artikel auszuspielen.

Schließlich sind noch die Geo-Tags zu erwähnen. Diese können helfen, die Seite lokal zuzuordnen, beispielsweise bei einer regionalen und branchenbasierten Suche. Dafür kann ein Geo-Tag-Generator verwendet werden.

Hervorhebung durch besondere HTML-Tags

Wichtige Begriffe im Seitentext, unter denen die Seite gefunden werden soll, können mit entsprechenden HTML-Tags hervorgehoben werden. Das hilft zum einem dem Nutzer, der die Seite besucht, wird aber auch von Suchmaschinen registriert. Auf diese Weise hervorgehobene Begriffe werden möglicherweise höher gewichtet. Wenn also bestimmte Keywords auf diese Weise markiert werden, erhöht das die Trefferwahrscheinlichkeit für diese Begriffe. Die wichtigsten Hervorhebungen sind:

- Überschriften (Tags <h1> bis <h6>, wobei <h1> die größte ist

- Fettschrift der wichtigen Keywords mit <strong> und <b>

- Listen über <li>-Tag. Anmerkung dazu: Es ist sehr wahrscheinlich, dass aufgelistete Begriffe (so genannte Bullets) höher gewichtet werden als normaler Fließtext.

Domain und URLs

Die Wahl der Domain spielt ebenfalls eine Rolle bei der Suchmaschinenoptimierung. Betrachten Sie die Domain als das Grundstück, auf dem Sie Ihre Homepage bauen. Ein Haus kann nur so gut sein wie das Grundstück, auf dem es steht. Daher ist hier besondere Sorgfalt zu empfehlen. Für das Ranking Ihrer Homepage in den Suchmaschinen ist unter anderem von Bedeutung, ob Ihre gewünschten Keywords im Domainnamen vorkommen. Auch das Alter der Domain, die Umgebung der Domain (welche anderen Domains liegen auf derselben IP-Adresse) und der Domainaufbau (Parameter wie Session-IDs etc.) sind relevant.

Die Domain oder Uniform Resource Locator einer Website (oft wird dafür die Abkürzung URL verwendet) spielt eine wichtige Rolle beim Suchmaschinenranking. Die Domain setzt sich zusammen aus dem Domainnamen (z.B. meine-seite), der Top-Level-Domanin (.de, .com etc.) und dem Namen der Verzeichnisse bzw. Seiten. Dazu kommt noch das optionale "www". Beispiel: http://meine-seite.de/index_investmentfonds.htm. Und beim Eigenheim gilt:

Einen interessanten Artikel zum Aufbau von Domains bietet Google.

Der Name der Domain und die Top-Level-Domain

Ein sprechender und einprägsamer Name, der eines oder mehrere Keywords enthält, ist sicherlich optimal, solange dies ohne Verrenkungen möglich ist. Vermeiden Sie zu lange Domainnamen. Eine bloße Aneinanderreihung von Keywords ist ebenfalls nicht sinnvoll - alleine schon wegen des dadurch erzeugten unseriösen Eindrucks. Zudem hat Google in einem Update keywordoptimierte Domains, die sogenannten Exact-Match-Domains (EMDs) abgewertet.

Was die Top-Level-Domain angeht, so ist für Webseiten mit Zielpublikum in Deutschland schon aufgrund der Bekanntheit .de zu bevorzugen. Die Nutzer kennen diese und haben mehr Vertrauen als zu exotischeren Top-Level-Domains wie .eu oder .biz. Dennoch ist es eine Erwägung wert, die Wunschdomain unter einer anderen Top-Level-Domain einzurichten, wenn sie unter .de nicht mehr frei ist.

Für internationale Webseiten gibt es verschiedene Alternativen unter den Top-Level-Domains. Die Bekannteste ist die .com-TLD.

Das Alter der Domain

Beachten Sie das Alter der Domain. Google zum Beispiel bewertet, wie lange es die Domain schon gibt. Es wird angenommen, dass ältere Domains normalerweise vertrauenswürdiger sind als frisch angelegte. Man kann eine Domain mit einem guten Wein vergleichen, der mit der Zeit an Qualität gewinnt. Ausgenommen sind natürlich Domains mit einer fragwürdigen Vorgeschichte.

Testen kann man das Alter der Domain mit Tools wie archive.org.

Hosting der Domain

Wo wird die Domain gehostet? Handelt es sich um einen eigenen Server, oder teilt sich die Domain eine IP-Adresse mit mehreren anderen Domains? Es gibt nur eine begrenzte Anzahl sogenannter IP-Adressen, was sich mit der Umstellung auf IPv6 deutlich entspannt. Die IP-Adressen bestehen im Gegensatz zu den lesbaren URLs nur aus Zahlen (Beispiel: 192.168.178.21).

Ein eigener Server mit eigener IP-Adresse bringt auf jeden Fall Vorteile in Punkto Schnelligkeit. Zudem vermeidet man, dass „böse“ Homepages, mit denen man sich die IP-Adresse teilt, zu Problemen mit Suchmaschinen führen können, weil deren negativer Status auf die eigene Homepage abfärbt. Sie können ganz einfach testen, welche anderen Domains sich noch unter Ihrer IP-Adresse tummeln:

- Ein Onlinetest ist zum Beispie auf der Seite Network-Tools.com möglich.

- Sehr gutes Tool: Quirk SearchStatus bietet auch noch zahlreiche andere, nützliche Funktionen wie die Anzeige der Meta-Tags oder der Keyword-Dichte

Funktionieren auch einzelne Teile Ihrer URLs?

Auch Teileingaben der URLssollten funktionieren: Die Eingabe von www.meine-seite.de/ebene1 sollte zum Beispiel genauso funktionieren wie www.meine-seite.de/ebene1/inhalt1.htm. Notfalls muss eine standardisierte Seite angezeigt werden, über die man auf die Startseite und in die wichtigsten Verzeichnisse springen kann.

Was passiert, wenn nicht vorhandene Seiten aufgerufen werden?

Gibt es eine selbst gestaltete 404-Seite? Der Serverfehler 404 bedeutet, dass eine aufgerufene Seite auf dem eigenen Server nicht gefunden wird, zum Beispiel, wenn sich der Aufrufende bei der Eingabe der URL verschrieben hat. In diesem Fall sollte vermieden werden, eine nicht ins Gesamtlayout passende Standardfehlerseite des Servers anzuzeigen, sondern dies mit einer selbst gestalteten und dafür optimierten Seite abzufangen, über die man zurück auf die Startseite gelangen kann.

Session-IDs in den URLs

Session-IDs sollten so weit wie möglich vermieden werden (Beispiel: www.meine-seite.de?id=126382). Anhand von Session-IDs kann ein Server die verschiedenen Besucher unterscheiden. Suchmaschinen mögen Session-IDs allerdings nicht. Das hat vor allem den Grund, dass die betreffende URL nach Ablauf der Session nicht mehr gültig ist, weil stetig neue IDs vergeben werden. Eine einmal indexierte URL mit Session-ID, die in den Suchergebnissen angezeigt wird, führt also später zu einem Fehler. Session-IDs sollten Sie daher - ebenso wie Cookies - nur dort einsetzen, wo sie unverzichtbar sind, z.B. bei Warenkörben und Shopping-Systemen, allgemein bei Bestellungen.

Vermeiden von Duplicate Content

Beachten Sie, dass Seiteninhalte nicht doppelt vorkommen (Duplicate Content oder kurz DC) oder zumindest von Suchmaschinen nicht doppelt indexiert werden. Das kann zum Beispiel geschehen, wenn URLs jeweils mit und ohne das vorangestellte "www" funktionieren (siehe Abschnitt weiter unten).

Doppelt indexierte Inhalte führen in Suchmaschinen leicht zur Abwertung der Relevanz einzelner Seiten. Zur Vermeidung lagern Sie am besten alle doppelten Seiten in ein eigenes Verzeichnis auf dem Server aus und schützen dieses gegen Indexierung durch die Suchmaschinen. Dies ist mit Hilfe der Datei „robots.txt“ möglich, die Sie auf Ihren Server legen.

Ein Beispiel für einen Eintrag in die robots.txt, der das Verzeichnis „test“ vor Indexierung schützt:

User-Agent: *

Disallow: /test/

Die Datei robots.txt muss ins Hauptverzeichnis des Webservers gelegt werden.

Einzelne Seiten Ihrer Homepage können Sie auch per Meta-Tag vor Indexierung schützen. Dazu schreiben Sie in den Header-Bereich einen entsprechenden Zusatz: <meta name="robots" content="noindex">. Normalerweise können Sie in Content-Management-Systemen für jede Seite einzeln bestimmen, ob diese indexiert werden darf. Beachten Sie aber bitte, dass die oben genannten Maßnahmen nicht mit Sicherheit vor Indexierung schützen. Die großen Suchmaschinen wie Google halten sich aber daran.

WWW oder nicht WWW?

Die eigene Homepage sollte nur über die „www“-Domain dargestellt werden. Beispiel: Bei Aufruf von http://meine-seite.de sollte sofort weitergeleitet werden auf http://www.meine-seite.de. Somit ist sichergestellt, dass die Inhalte nur einmal von den Suchmaschinen indexiert werden (und nicht jeweils für die Domain mit und ohne "www") und sich die Relevanz auf eine Domain konzentriert. Die bevorzugte Domain (mit oder ohne „www“) für die Indexierung bei Google kann auch über die Google Webmaster-Tools eingestellt werden. Bei Google finden Sie zudem einen interessanten Artikel über die bevorzugte Domain (mit oder ohne "WWW").

Technische SEO

Die letzte Säule der Onsite-Optimierung bildet die technische SEO. Sie hat einen sehr großen Einfluss auf die Rankings, die eine Webseite in den Suchergebnissen von Google erreichen kann. In den letzten Monaten und Jahren ist die technische SEO immer wichtiger geworden. Das liegt vor allem an den ständig steigenden Ansprüchen, die Google an Webseiten stellt. Dazu gehören vor allem möglichst niedrige Ladezeiten, eine sichere Übertragung der Daten und die optimale Darstellung der Inhalte auch auf Mobilgeräten.

Folgende Hauptbestandteile der technischen SEO lassen sich unterscheiden:

Performance und Ladezeiten: Umso schneller eine Seite geladen werden kann, desto geringer ist das Risiko, dass Nutzer während des Ladens abspringen. Vor allem im mobilen Web, indem die verfügbare Bandbreite oftmals eingeschränkt ist, kommt es auf schlanke und effiziente Webseitentechnologie an. Ein Ansatz, dem zu begegnen, stellt Googles AMP-Initiative dar. Dort wird versucht, mittels reduziertem HTML und JavaScript sowie unter Einsatz eines Content Delivery Networks (CDNs) die Ladezeiten zu begrenzen. Die Ladezeiten von Webseiten kann man unter anderem mit Googles PageSpeed Insights messen. Das Tool zeigt einen Wert zwischen 0 und 100 an, wobei zwischen Desktop und Mobile unterschieden wird. Außerdem erhält man Hinweise zu mögliche Verbesserungen.

Sichere Datenübertragung: Google fördert und unterstützt den Einsatz von HTTPS. Dabei geht es um die Verwendung des vergleichsweise sicheren TLS-Protokolls, bei dem die zwischen Client und Server übertragenen Daten verschlüsselt werden. Das ist nicht nur für eingegebene Nutzerdaten wichtig. Per HTTPS kann auch gewährleistet werden, dass die Inhalte der Webseiten ohne Manipulation der Inhalte bei den Besuchern der Seite ankommen. Google verspricht für Webseiten mit HTTPS einen leichten Rankingbonus.

Mobilfreundlichkeit: Seit April 2015 erhalten mobilfreundliche Seiten einen Rankingvorteil bei Google. Mobilfreundlich sind Webseiten dann, wenn sie nicht nur auf dem großen Bildschirm von Desktop-Rechnern gut aussehen, sondern auch auf kleinen Smartphone-Displays und Tablets. Ob eine Webseite mobilfreundlich ist, kann man am besten mit Googles Mobile-Friendly Testing Tool ausprobieren. Grundsätzlich gibt es mehrere Möglichkeiten, eine Webseite mobilfreundlich zu machen: Entweder verwendet man Responsive Design, das die Darstellung der Webseite an die jeweiligen Gegebenheiten des genutzten Geräts anpasst, oder man liefert unterschiedliche, jeweils optimierte Versionen der Webseite für unterschiedliche Geräte aus. Übrigens wird Mobilfreundlichkeit bald noch wichtiger, denn Google wird demnächst auf einen mobil-dominierten Index umstellen. Dann zählen in erster Linie die mobilen Inhalte.

Indexierbarkeit / Crawlability: Was nutzen die besten Inhalte, wenn Google sie nicht erkennen, crawlen und indexieren kann. Deshalb ist es wichtig, auf die Crawlbarkeit aller Inhalte zu achten. Dazu gehören nicht nur die einzelnen Seiten selbst, sondern auch zugehörige CSS- und JavaScript-Dateien. Man muss darauf achten, dass keine wichtigen Dateien per robots.txt gesperrt sind. Ob alle wichtigen Inhalte crawlbar sind, kann man am besten per Google Search Console überprüfen. Dort erhält man einen Hinweis, wenn wichtige Dateien gesperrt sind. Ebenfalls in der Google Search Console gibt es eine Funktion mit dem Namen "Abruf wie durch Google". Damit lässt sich testen, wie Google eine Webseite sieht.

Aktuelle Nachrichten und Beiträge zur Technischen SEO gibt es hier.

SEO von Anfang an

Kurz gesagt sollte die Onsite-Optimierung bereits mit der Planung der Homepage beginnen:

- Wie soll die Gesamtgliederung des Webauftritts aussehen (Inhaltsverzeichnis, Sitemap)?

- Wie soll die Gliederung der einzelnen Seiten aussehen (Textabschnitte, Bilder)?

- Wie wird die Navigation gestaltet?

- Auf welche Inhalte kann ich verzichten, weil sie dem Besucher keinen Mehrwert bringen?

- Was soll auf die Startseite?

- Welche Technologie verwende ich (selbst erstelltes HTML, Content Management System etc.)?

- Wie sieht meine Zielgruppe aus und unter welchen Keywords möchte ich gefunden werden?

Wem das jetzt alles zu viel war - kein Problem! Auf unserer SEO-Checkliste gibt es die wichtigsten Prüfkriterien in einer übersichtlichen Liste.

Titelbild © bloomua - Fotolia.com

Verwandte Beiträge

Google nutzt Sitemaps nur, wenn es von den Inhalten der Website überzeugt ist