Google: kein Zeichen für schlechte Qualität, wenn Seiten nicht indexiert werden

Wenn Google einzele URLs einer Website nicht indexiert, muss das kein Zeichen dafür sein, dass Google die Qualität der Website als schlecht bewertet.

Wenn Google einzele URLs einer Website nicht indexiert, muss das kein Zeichen dafür sein, dass Google die Qualität der Website als schlecht bewertet.

Bei den meisten Websites dürfte ein Blick in den Report zur Indexabdeckung in der Google Search Console mehr oder weniger URLs anzeigen, die nicht indexiert sind. Dabei gibt es verschiedene Gründe, die im Report genannt werden, wie zum Beispiel:

- Gefunden, aber nicht indexiert

- Gecrawlt, aber nicht indexiert

- Seite nicht gefunden (404)

- Crawling-Anomalie

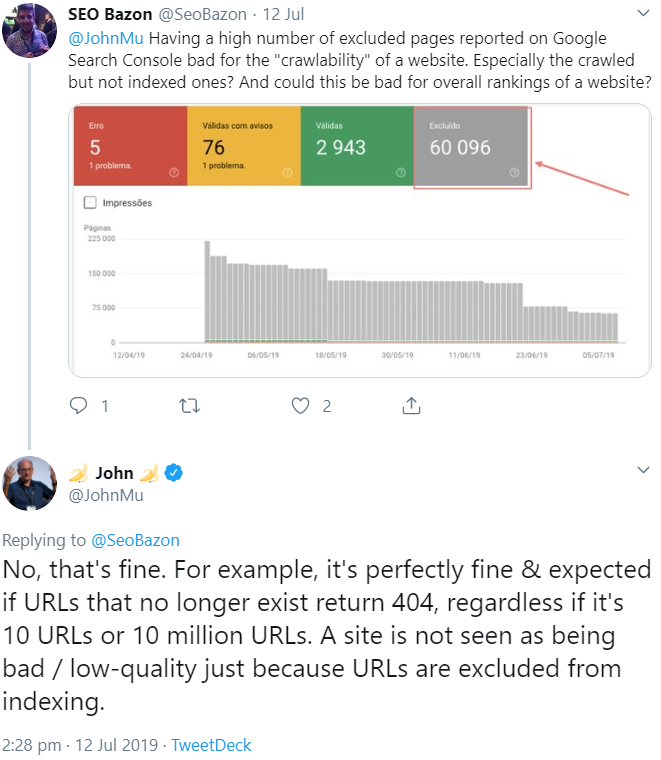

Selbst wenn eine größere Anzahl von URLs bzw. Unterseiten von Google als nicht indexiert gemeldet werden, muss das nicht bedeuten, dass Google die Qualität der Website insgesamt als schlecht bewertet. Darauf wies Johannes Müller per Twitter hin:

So sei es zum Beispiel normal, dass eine nicht bestehende URL einen 404-Status liefere. Dabei komme es nicht darauf an, ob es sich um 10 URLs oder 10 Millionen URLs handele. Nur wenn URLs von der Indexierung ausgeschlossen sind, müsse eine Website nicht als qualitativ schlecht betrachtet werden.

Allerdings sollte man zumindest in den Fällen aufmerksam werden, in denen URLs bzw. Seiten verfügbar sind und von Google trotz Crawlens nicht indexiert werden. Dann kann es nämlich tatsächlich sein, dass Google die Inhalte der Seiten als nicht relevant genug für die Suche betrachtet. Das kann daran liegen, dass die Inhalte zu oberflächlich sind oder dass es bereits andere Seiten mit ähnlichen Inhalten gibt.

Titelbild: Copyright Justin - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

Google Search Console: Indexierungsbericht seit fast einem Monat nicht mehr aktualisiert