Spam-Links: Sperren per robots.txt genügt nicht

Das Sperren von Seiten mit Spam-Links per robots.txt bewirkt nicht, dass Google die vorhandenen Links ignoriert.

Links, die gegen die Google Webmaster-Richtlinien verstoßen, können für eine Website zum Problem werden. Gibt es beispielsweise einen großen Anteil gekaufter Links, kann dies zu einer manuellen Maßnahme durch Google führen.

Es gibt verschiedene Möglichkeiten, solche Links loszuwerden. Idealerweise werden die Links gelöscht, doch es ist auch möglich, sie mithilfe des Disavow-Tools abzuwerten. Auch dann berücksichtigt Google die Links nicht mehr.

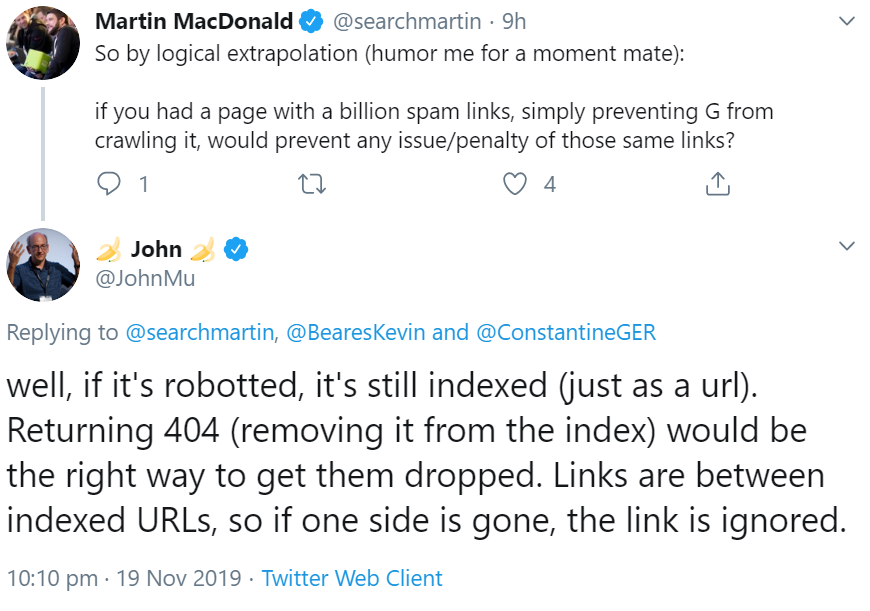

Was allerdings nicht funktioniert, ist, die Seiten mit den betreffenden Links per robots.txt zu sperren, so dass Google sie nicht mehr crawlen kann. Wie Johannes Müller per Twitter schrieb, bleiben die Seiten auch nach dem Sperren indexiert. Damit bleiben auch die Links bestehen. Die richtige Lösung sei es, für die betreffenden Seiten den Status 404 zu senden, damit sie aus dem Index entfernt werden, denn wenn eine Seite zwischen zwei verlinkten Seiten entfällt, dann wird auch der Link nicht mehr gewertet:

Ohnehin ist es keine gute Idee, indexierte Seiten per robots.txt zu sperren. Das bewirkt nämlich lediglich, dass Google die Seiten nicht mehr crawlt. Sie können aber immer noch in den Suchergebnissen erscheinen - allerdings ohne inhaltliche Angaben in den Snippets.

SEO-Newsletter bestellen

Verwandte Beiträge

Google: Robots.txt sollte nicht dynamisch geändert werden