Google: Cross-Site-Sitemaps können auch ohne Nennung in robots.txt genutzt werden

Auch um XML-Sitemaps zu verwenden, die unter einer anderen Domain laufen, müssen diese nicht in der robots.txt genannt werden.

Auch um XML-Sitemaps zu verwenden, die unter einer anderen Domain laufen, müssen diese nicht in der robots.txt genannt werden.

In der robots.txt kann man nicht nur angeben, welche URLs und Pfade gecrawlt werden dürfen und welche nicht, sondern man kann hier auch einen Verweis auf eine XML-Sitemap angeben. Zwingend notwendig ist das aber nicht. Damit Google eine Sitemap finden kann, genügt es, diese per Google Search Console anzumelden.

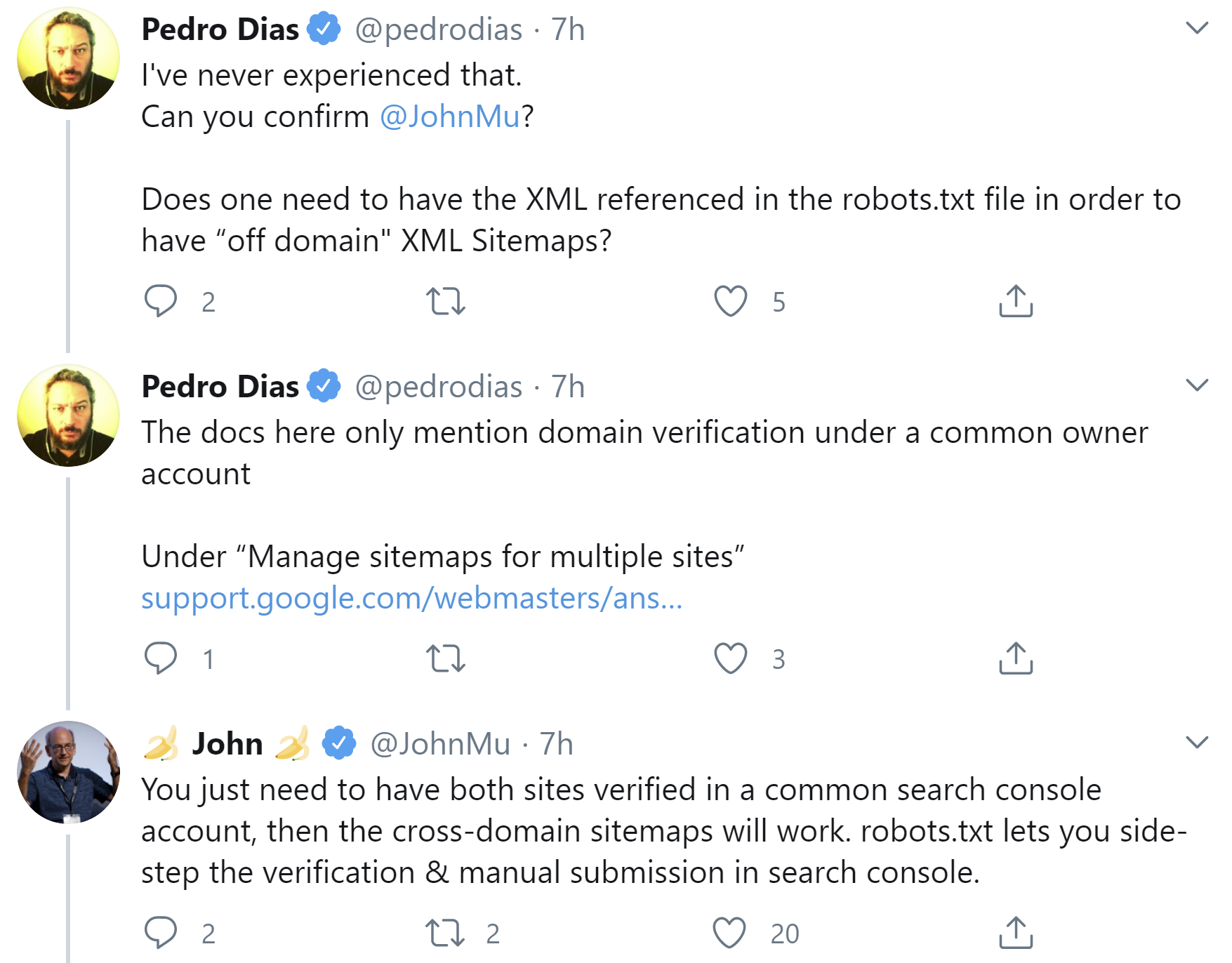

Doch wie sieht es aus, wenn eine Sitemap unter einer anderen Domain läuft als die jeweilige Website? Müssen solche sogenannten Cross-Site-Sitemaps dann in der robots.txt genannt werden? Um diese Frage ging es gerade in einer Diskussion auf Twitter. Die klare Antwort von John Müller: Es genügt, die Sitemaps per Google Search Console anzumelden. Die betreffenden Domains müssen dabei einem gemeinsamen Nutzer zugeordnet sein. Durch die Angabe der Sitemap in der robots.txt könne man sich diesen Schritt aber sparen:

Das Nennen der XML-Sitemap in der robots.txt erfordert nur wenig Aufwand und lässt sich mit vielen Plugins automatisch bewerkstelligen. Es hilft Google zu erkennen, wo sich die Sitemap der Website befindet, auch ohne Search Console. Aus diesen Gründen ist dieses Vorehen empfehlenswert.

Titelbild: Copyright teguhjatipras - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

Google: Wenn sich Sitemap ändert, dann auch lastmod in Sitemap-Index aktualisieren