Google indexiert Seite ohne Inhalt: Page Speed ist nicht die Ursache

Wenn Google Seiten ohne Inhalte indexiert, ist eine zu hohe Ladezeit nicht der Grund dafür. Es gibt eine Reihe anderer möglicher Ursachen.

Wenn Google Seiten ohne Inhalte indexiert, ist eine zu hohe Ladezeit nicht der Grund dafür. Es gibt eine Reihe anderer möglicher Ursachen.

In seltenen Fällen kann es passieren, dass Google Seiten ohne Inhalte indexiert. Ein Beispiel dafür sind Seiten, die per robots.txt gesperrt sind. In einem solchen Fall kann Google die Seiten nicht crawlen und folglich auch nicht auf ihre Inhalte zugreifen. Eine Indexierung der Seiten ist aber trotz Sperrung per robots.txt möglich, zum Beispiel dann, wenn externe Links auf die Seiten verweisen.

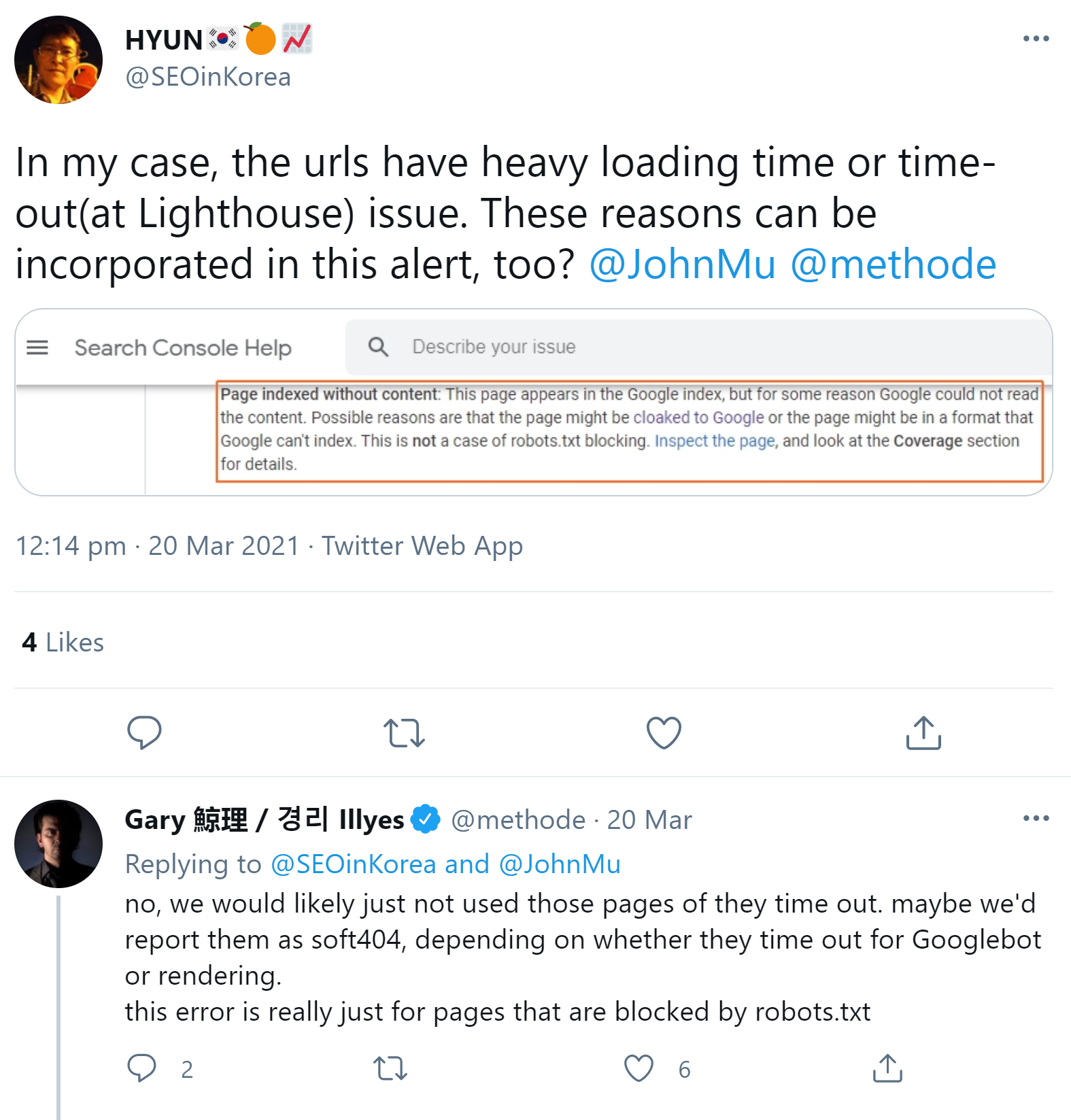

Es gibt aber auch andere Ursachen für eine Indexierung ohne Inhalte. Für solche Fälle hält Google eine spezielle Fehlermeldung bereit, die in der Google Search Console erscheinen kann. In der Fehlermeldung heißt es, die Seite könne möglicherweise für Google "cloaked" sein, also für den Googlebot andere Inhalte zeigen als für normale Nutzer. Möglich ist auch, dass die Seite in einem Format vorliegt, das Google nicht indexieren kann.

Auf die Frage, ob auch eine zu hohe Ladezeit zu einer Indexierung ohne Inhalte führen könne, antwortete Gary Illyes von Google, solche Seiten würden vermutlich einfach von Google nicht verwendet oder als Soft-404 gemeldet, je nachdem, ob ein Timeout für den Googlebot oder beim Rendern passiere. Weiter schrieb Illyes, dass die Fehlermeldung für Webseiten gedacht sei, die per robots.txt gesperrt sind - dabei wird genau dieser Fall in der Fehlermeldung ausgeschlossen: "This is not a case of robots.txt blocking."

Eine zu hohe Ladezeit als Ursache für eine Indexierung ohne Inhalte lässt sich demnach aber ausschließen.

SEO-Newsletter bestellen

Verwandte Beiträge

Google Search Console: Indexierungsbericht wieder aktuell