SEOkomm 2017 - Live-Blog direkt von der Veranstaltung

Jetzt geht es los, die SEOkomm 2017 beginnt. Die wichtigsten News und Erkenntnisse gibt es hier im Live-Blog.

Jetzt geht es los, die SEOkomm 2017 beginnt. Die wichtigsten News und Erkenntnisse gibt es hier im Live-Blog.

Mit der SEOkomm 2017 findet das SEO-Veranstaltungsjahr seinen vorläufigen Höhepunkt. Wieder einmal haben sich in Salzburg viele der bekanntesten SEOs und Online-Marketer versammelt, um über aktuelle Themen und Trends in der Suchmaschinenoptimierung zu sprechen.

Einen Ausblick auf die Highlights der SEOkomm findet Ihr übrigens im Precap. Dort gibt es eine Auswahl der vielversprechendsten Vorträge sowie eine Liste der Speaker.

Den Anfang wird um 09.00 Uhr Tobias Fox mit seiner Eröffnung machen, danach wird Marcus Tandler vermutlich wieder mindestens 150 Folien in 45 Minuten präsentieren.

Live-Blog

17.56: So, das war's mit dem Live-Blog von der SEOkomm 2017. Viel Spaß beim Lesen und bis zum nächsten Mal!

17:51: Shopify als gutes SaaS-Produkt. Man kann aber auch nur den Shopify-Checkoutprozess verwenden. Applikation muss ausreichend getestet werden. Loader.io, stormforger.com oder JMeter sind gute Tools. Dynamische Parameter müssen beim Caching auch von statischen Inhalten berücksichtigt werden. Und: Habt einen Plan B, falls etwas schiefgeht!

17:50: Nicht nur die Webseite muss skaliert werden, sondern die komplette Prozesskette!

17:48: Beispiel: 40 Millionen Requests in nur 30 Minuten während der Ausstrahlung von "Höhle der Löwen" - ohne CDN wäre das kaum möglich gewesen.

17:47: Redis schafft für Datenbank-Transaktionen wesentlich mehr Performance

17:46: Cloudflare liefert als CDN für statische Webseiten gute Dienste.

17:39: So - Endspurt! Letzter Vortrag: "Yay! Wir sind bei 'Die Höhle der Löwen' - und jetzt?" - Insights in die Hochlastoptimierung mit Dennis Oderwald

17:31: Auch Apple Maps im Auge behalten wegen direkter Navigation

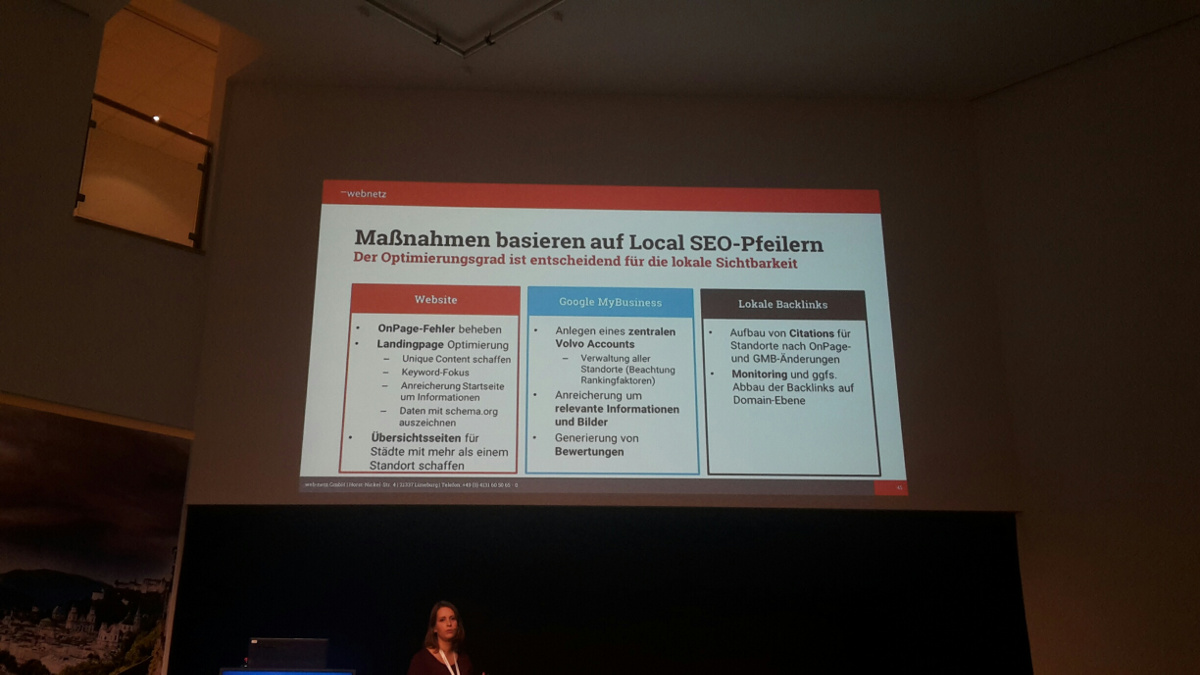

17:24: Überblick über Local SEO-Maßnahmen:

17.20: Aha, Pipes ("|") sollte man für lokale Snippets nicht verwenden, weil diese dann nicht angezeigt werden - interessant.

17:12: Beispiel Volvo: Konkurrenz mit anderen Verkaufsseiten einzelner Händler sowie zwischen mehreren Händlern in einer Stadt sind ein Problem

17:08: Problem mit Duplicate Content bei Ketten und Vertragshändlern, die alle den gleichen Teasertext verwenden

17:01: Ziel in allen lokal relevanten Bereichen zu ranken, als Google My Business (Local Panel), im Local Pack und in den organischen Ergebnissen.

16:59: Sprachsuchen haben überdurchschnittlich oft einen Ortsbezug.

16:57: Anteil der lokalen Suchergebnisse steigt an. Das gilt insbesonders für generische Suchanfragen wie "Friseur".

16:46: Der nächste Vortrag steht an: "How to rock in Local SEO" mit Nicole Mank

16:30: Security Header setzen! Kann Schutz gegen negative Attacken bieten. Domainqualität kann gesteigert werden. Schutz vor Cross Site Scripting (XSS).

16:29: Download the Internet! Common Crawl stellt monatlich einen Crawl von mehren Milliarden Webseiten zur Verfügung. Diese Daten können für eigene Auswertungen oder für den Aufbau eigener Indizes genutzt werden.

16:26: schema.org/question und schema.org/answer erlauben das Kennzeichnen von Fragen und Antworten. Erhöht Chance auf eine Answer-Box in Google! schema.org/linkrole und schema.org/linkrelationship erlauben möglicherweise später das Auszeichnen von Canonicals und Hreflangs. Vielleicht auch hilfreich: schema.org/publictoilet

16:23: Octoparse: Tool für das Webscraping. Kann vor allem für das Monitoring von Wettbewerbern genutzt werden. Wurden zum Beispiel neue Seiten angelegt, wurden strukturierte Daten hinzugefügt? Wie oft werden Inhalte aktualisiert? Wie ändern sich die internen Verlinkungen und Redirects? Wurden Seiten abgeschaltet? Gibt es Änderungen am Header, an den Meta-Tags? Man kann auch ein Archiv für Rückverfolgungen einrichten.

16:20: Browser Fingerprinting: Einzelne Nutzer lassen sich durch die Kombination verschiedener Browserdaten eindeutig zuordnen, zum Beispiel anhand des Accept Language-Headers, der Zeitzone, den installierten Plugins und vielen mehr. Sogar die Nutzung der Grafikkarte durch den Browser kann ausgewertet werden, um Rückschlüsse auf einzelne Nutzer zu erhalten. Tool für das Browser Fingerprinting ist zum Beispiel Unique Machine.

16:17: Keyword Hero: Hilft im Umgang mit den nicht angezeigten Keyword-Daten ("not provided") aus Google Analytics.

16:15: Logfileanalyse Big Query und Google Data Studio. Logstash und Kibana sind derzeit sehr im Trend. Leicht aufzusetzen.

16:12: Virtual Reality ist inzwischen auch im Browser angekommen. Kann auch für das Online-Marketing interessant sein.

16:06: Progressive Web Apps verhalten sich wie native Apps. Webseiten und Apps wachsen zusammen. Service Worker arbeiten im Hintergrund und können zum Beispiel Push Notifications versenden. Progressive Web Apps laufen nur auf HTTPS!

16:01: JavaScript-Rendering - auf Client- oder auf Serverseite? Tipp: Konzentrieren auf die Serverseite. Indexierbare URLs und Pushstate müssen richtig behandelt werden. Kein JavaScript per robots.txt sperren. Wichtig ist auch das Handling der Fehlercodes (404, 410). Unterschied zwischen Inline- und externem JavaScript. Prerendering-Services wie Rendertron können helfen.

15:58: JavaScript-Frameworks werden immer populärer, Beispiele Angular und React. Angular stammt von Google, React geht auf Facebook zurück. Nach wie vor liegt jedoch JQuery mit fast 75 Prozent ganz vorne. Besonders schnell ist jedoch Preact - 86 Millisekunden, während Angular fast eine Sekunde benötigt! Preact-JavaScript hat zudem eine wesentlich geringere Dateigröße als andere Frameworks.

15:55: FLIF: Fresh Lossless Image Format - kleiner als andere Formate mit hoher Qualität, auch beim Skalieren. Allerdings noch nicht aktiv in Browsern. Im Auge behalten!

15:53: Los geht's mit "10 technische SEO-Hacks, die du noch nicht kennst" mit Dominik Wojcik!

15:25: Call to Action wie Share-Buttons immer möglichst sichtbar einbinden!

15:23: Call to Action: Was soll der Nutzer machen, und warum soll er es tun? Beides muss deutlich erkennbar sein. Die Farbe des Buttons spielt keine Rolle!

15:22: Jeder Satz sollte Vorteile und Argumente für das angebotene Produkt oder die angebotene Dienstleistung enthalten. Keine Phrasen und Worthülsen verwenden.

15:18: Skim / Scan / Read. Vom oberflächlichen bis zum genauen Lesen von Texten. Danach erst die Konversion. Deshalb: die wichtigen Worte an den Anfang packen und nicht Dinge schreiben wie "Herzlich willkommen", "Wussten Sie schon" und Ähnliches.

15:17: Hört nicht auf Euer Bauchgefühl!!!!

15:15: Die ersten und die letzten Worte eines Textes erhalten die größe Aufmerksamkeit.

15:10: Beim A/B-Testing besser nur einzelne Elemente auf der Seite gesondert austauschen, weil ansonsten Mischeffekte entstehen können und unklar ist, welches der Beitrag der einzelnen Elemente ist.

15:01: Hautfarbe und farbliche Kontraste ziehen auf einer Seite viel Aufmerksamkeit an. Wichtig sind aussagekräftige Überschriften. Vertrauensbildende Maßnahmen wie Testimonials sind hilfreich.

15:00: Mehr Content, User Signals und UX mit Nils Kattau beginnt gerade

14:36: Kann ein langes Disavow-File negative Auswirkungen auf die Rankings haben? Nicht notwendigerweise. Disavow gibt keine Signale, sondern ist nur ein technisches Hilfsmittel, um sich von bestimmten Links zu distanzieren.

14:34: Hreflang bei einer .com- und einer .de-Seite, bei denen es zu Überscheidungen in der Suche kommt. Wird das besser, wenn die .com- durch eine .at-Seite ersetzt wird? Das kommt laut Müller auf den Zuschnitt und die Zielländer an. Muss am besten ausprobiert werden.

14:32: Wie sieht es mit responsivem Content im Hinblick auf den neuen Index aus? Was ist, wenn die Inhalte für die mobile Seite kürzer sind? Dann kann es laut Müller passieren, dass beide Contentvarianten indexiert werden. Das sollte man am besten ausführlich testen.

14:31: Page Speed: Was genau wird gemessen? Time to First Byte, Dom Ready...Müller kann dazu nichts Genaues sagen.

14:26: Wie bewertet Google die Ladezeit bei Progressive Web Apps, und wie wird sich der neue Google-Index auf Progressive Web Apps auswirken? Der Crawling-Prozess für solche Seiten ist wesentlich aufwändiger als bei normalen HTML-Seiten. Daher sollte man diese sehr gut testen, zum Beispiel mit "Abruf wie durch Google". Viele SEO-Tools kommen mit PWAs noch nicht klar. Daher muss genau überlegt werden, wie solche Seiten getestet werden können. Bezüglich Mobile First wird es im Hinblick auf PWAs wohl keine Änderungen geben.

14:23: Crawling-Budget - lohnt es sich, bestimmte Seiten vom Crawlen auszuschließen? Laut Müller gibt es hier mehr als genug Spielraum, damit Google normale Webseiten komplett crawlen kann. Daher lohnt sich das Blocken per robots.txt nicht. Besser ist es, Canonicals, Redirects und die Parameter-Funktion in der Search Console zu nutzen.

14:19: Kann es sein, dass trotz des richtigen Setzens von hreflang in der deutschen Suche englischsprachige Ergebnisse erscheinen? Wichtig ist laut Müller, dass sich die Seiten sauber unterscheiden lassen, zum Beispiel auch durch das Layout. Interessant auch: Titel und Snippets bei einer "site:"-Abfrage unterscheiden sich oft von denen bei normalen Suchanfragen.

14:15: Wie geht Google mit schlechten Links um? Sind diese jetzt nicht mehr relevant, also werden von Google ignoriert? Laut Müller sind gekaufte und auf andere Weise gewonnene Links, die gegen die Webmaster-Richtlinien verstoßen, problematisch. Das Ignorieren von Links klappt nicht immer wie gewünscht. Das Webspam-Team wird auch weiterhin manuelle Maßnahmen vornehmen. Deshalb sollte man zur Sicherheit mit Disavow arbeiten.

14:11: Warum landen Seiten mit Canonical-Link auf ander Seiten trotzdem manchmal im Index? Laut Müller sucht Google immer die relvantesten Seiten. Dabei gibt es neben dem Canonical auch andere Signale wie zum Beispiel die interne Verlinkung. Somit kann es geschehen, dass nicht die Canonical-Seite ausgewählt wird, sondern eine andere. Man sollte immer versuchen, alle Signale konsistent zu setzen. Es ändert aber nichts an den Rankings, wenn Google eine andere Seite auswählt.

14:05: Jetzt geht's los - John Müller beginnt

13:46: Gruppenfoto mit den Veranstaltern und den Speakern der SEOkomm:

13:43: Die Mittagspause ist fast vorbei. Als nächstes steht Johannes Müller auf der Agenda, Beginn etwa um 14.05 Uhr.

12:24: Wichtige Aussage (aus 2015): "If you care about SEO, you still need server-side rendered content."

12:18: Tools für das Prerendering des JavaScripts auf dem Server sind verfügbar, zum Beispiel SEO4AJAX

12:15: Alles, was nach fünf Sekunden nicht geladen ist, wird von Google nicht mehr indexiert. Ist das wirklich so?

12:13: Screaming Frog kann JavaScript crawlen und rendern, und zwar seit Version 6

12:11: Wichtig auch: Außer Google kann keine Suchmaschine JavaScript crawlen!

12:08: Ups, Google kann noch kein Angular 2 crawlen???

12:03: Puppeteer: Headless Browserversion von Google Chrome steuern

12:00: Wichtiger Unterschied zu klassischen Webseiten: JavaScript muss in der Regel im Client ausgeführt werden. Daher muss der Crawler das ebenfalls beherrschen.

11:52: Weiter geht es mit Artur Kosch und dem Thema JavaScript SEO: Crawling, Indexierung und Auditing von JavaScript-Websites

11:39: Aus Sicht des Datenschutzes eher bedenklich: Man kann komplette Transaktionsverläufe für einzelne Nutzer betrachten. Es gibt Daten zu einem Demo-Konto, die man in das eigene Konto zum Testen importieren kann. URL wird in Markus' Folien nachgeliefert.

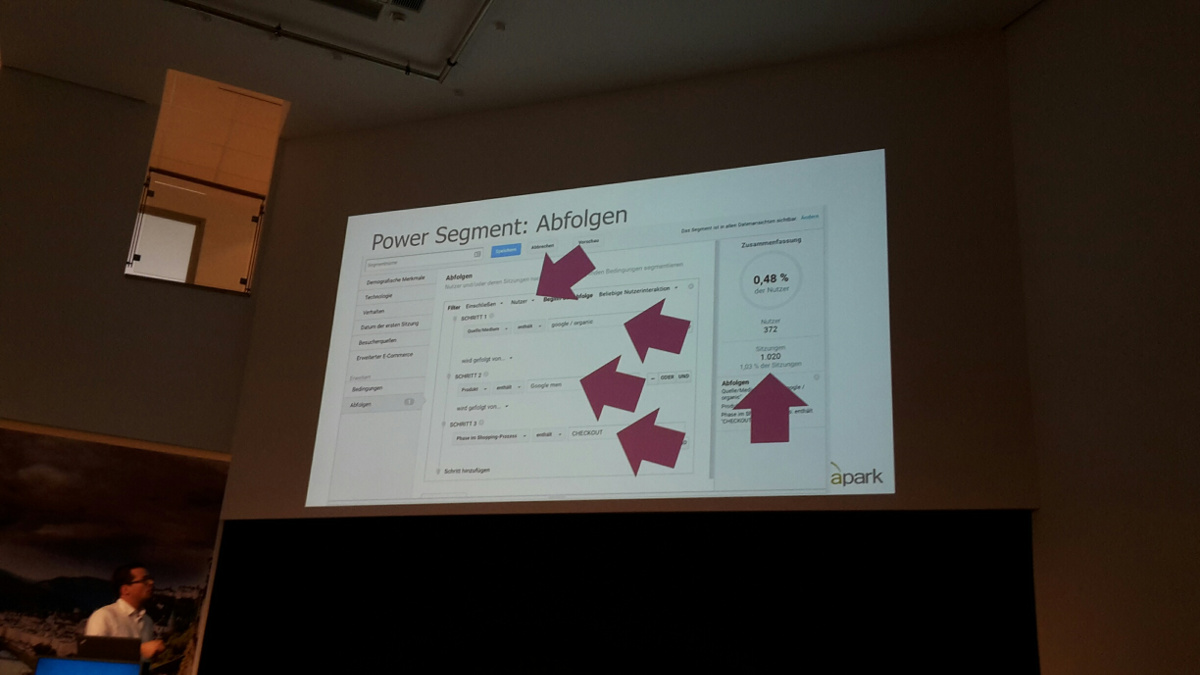

11:23: Die Daten aus Analytics zeigen genau, an welcher Stelle die Kunden ausgestiegen sind. Haben sie sich schon auf der Detailseite verabschiedet, oder erst nach dem Hinzufügen zum Warenkorb? Interessant vor allem für Remarketing-Strategien.

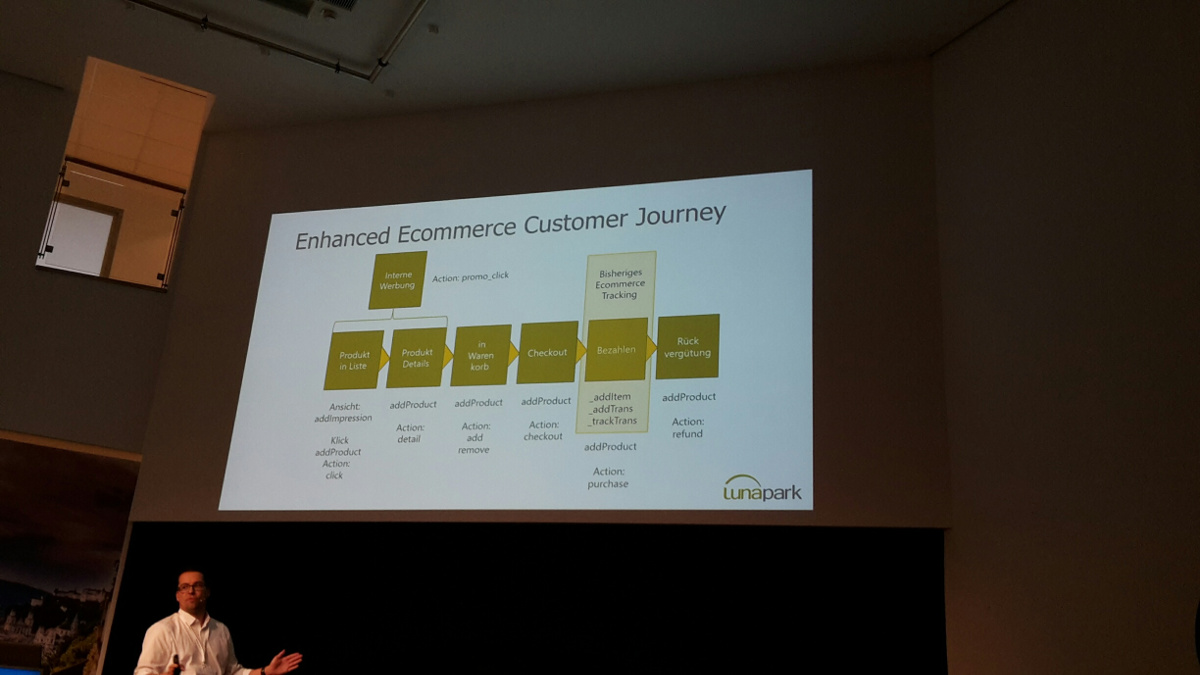

11:10: Enhanced E-Commerce-Tracking in Google Analytics liefert zusätzliche Daten. Liefert nicht nur Daten zu den Bestellungen, sondern auch Impressionen wie "Produkt in Liste" oder "interne Werbung". Damit lässt sich die komplette Customer Journey abdecken. Man kann zusätzlich bestimmte Profile wie zum Beispiel für neue und wiederkehrende Besucher anlegen. Google Analytics erlaubt außerdem das Anlegen eines zur Webseite oder zum Shop passenden Bezahlprozesses.

11:06: Jetzt geht es weiter mit Markus Vollmert zum Thema Shops mit Google Analytics E-Commerce Tracking optimieren

10:45: Ok, 20 Minuten Pause :-)

10:40: Interner PageRank gibt wichtige Auskünfte über die Bedeutung der URLs auf einer Seite. Siehe dazu auch den Beitrag auf SEO Südwest.

10:34: Content identifizieren, den die Nutzer nicht mögen. Dazu können Nutzersignale wie die Absprungrate, die Verweildauer, die Scrolltiefe (siehe Google Tag Manager) und die Element Visibility (ebenfalls Google Tag Manager) genutzt werden. Formel für den User Engagement Index: (100-Absprungrate+1)*log(Verweildauer+1)*Scrolltiefe

10:28: kurzer Exkurs ins maschinelle Lernen. Clustering, Support Vector Machines..Aber was bringt dieses Wissen für die SEO? Idee: erkennen von Thin Content. Dabei werden verschiedene URLs betrachtet und manuell in die Kategorie "Thin Content" oder "kein Thin Content" eingeteilt. Mit diesen Trainingsdaten können die Algorithmen des maschinellen Lernens trainiert werden. Diese können dann die weiteren Daten zu Clustern zusammenfassen. Mit dem Rapidminer kann man sich solche Systeme einfach zusammenklicken. Dazu kann man zum Beispiel Daten aus der GSC zu Soft-404ern verwenden, die am besten von verschiedenn Domains stammen sollten.

10:25: Idee: URLs in eine Matrix unterteilt nach Anzahl Klicks und Impressionen eintragen. Daraus kann man zum Beispiel ablesen, welche URLs viele Klicks bei wenig Impressione erhalten.

10:22: Statt besserer Rankings kann man versuchen, durch bessere Snippets mehr Klicks auf derselben Position zu erhalten. Dazu sollte man sich zunächst überlegen, welches die durchschnittliche CTR auf einer Position ist. Das hängt beispielsbeise ab von Brand / Non-Brand, mobil oder Desktop, Money-Keyword etc.

10:21: Durchschnittliche Position in der GSC wird aufgrund einer speziellen Formel berechnet. Siehe dazu die Google-Doku

10:16: Datenorientiertes SEO basiert auf Ideen, die priorisiert werden müssen. Dazu kommen Monitoring- und Alerting-Funktionen, die bei Problemen automatisch arbeiten. Daten sollen aber auch von sich aus Anstöße zum Handeln liefern. Problem: Die Aggregation der Daten aus der Search Console wird oftmals nicht richtig vorgenommen. Es müssen die richtigen Properties angelegt werden (www, ohne www, http, https etc.). Am besten die API verwenden. Daten sollten jeden Tag abgerufen und gespeichert werden.

10:14: Big Data - für alle ein Thema?

10:11: Los geht's - Sebastian Erlhofer ist auf der Bühne. Thema: Datenorientiertes SEO mit Fokus auf die Google Search Console

10:03: Kurze Pause auf Track 1, dann kommt Sebastian Erlhofer auf die Bühne. Es wird um die Datenauswertung aus der Google Search Console gehen.

10:00: Marcus ist fertig, 420 Folien pünktlich abgeliefert!

09:59: "Abruf wie durch Google" in der Search Console - kann für "Echtzeit-SEO" genutzt werden, gerade auch für die schnelle Anpassung von Featured Snippets

09:50: Voice Search: Google wird "präsentationsagnostisch". 2020 sollen bereits 50 Prozent der Suchanfragen per Voice Search erfolgen. Wichtig wird es sein, die Fragen der Nutzer zu antiziperen und aufzugreifen. Dienste wie "Answer the Public" dabei empfehlenswert.

09:46: Kommt nach "Mobile First Indexing" bald "Cloud First Indexing"? Wird die Google-Cloud bald verbindliche Grundlage? Google bräuchte dann weniger Crawling-Ressourcen und hätte mehr Einblicke in die Nutzerdaten. Crawling dagegen skaliert schlecht und ist wenig effizient. Google will zukünftig Inhalte aus WordPress direkt extrahieren können. Google benötigt also direkten Zugang zu den Daten. URLs würden hier nur stören.

09:42: Die Bedeutung strukturierter Daten wird weiter steigen.

09:40: Werden URLs irgendwann nicht mehr in der Google-Suche angezeigt? Der Großteil der Daten liegt inzwischen ohne URL vor. Das erhöht dann die Chancen von Apps. Zukünftig kommt es mehr auf die Ladezeit und das Engagement an.

09:38: Laut Marcus wird Mobile First-Index, Googles neuer Index, eine Revolution, der nächste große Entwicklungsschritt für Google. Mobile First und Desktop Second - der mobile Markt ist attraktiver und zukunftssicher. Dektop stagniert. Nur im Büro ist Desktop noch bedeutsamer. Marktanteil von Bing in den USA ist nur für Desktop relevant. Weltweit dominiert Google 95 Prozent des weltweiten mobilen Suche-Traffics.

09:37: Progressive Web Apps sind ebenfalls im Trend. Noch fehlt es aber an Unterstützung durch Apple (Stichwort "Service Worker")

09:34: Page Speed und AMP sind wichtges Thema

09:32: Marcus zeigt den Knowledge Based Trust

09:30: SEO schafft Chancen, die durch eine gute Performance der Seite genutzt werden müssen. Deshalb in der Search Console auf den Zusammenhang zwischen Position und CTR achten. Wenn die CTR für gute Positionen gering ist, stimmt etwas nicht.

09.29: Die CTR bei navigationalen Suchanfragen ist normalerweise unterhalb von Position eins sehr gering

09:27: Vorsicht bei der Betrachtung der CTR in der Search Console: Durch Sitelinks kann es zu Verfälschungen kommen

09.22: N-grams und WDF-IDF sind laut Marcus immer noch gute Signale

09.21: Anscheinend gibt es ein Feature für die Darstellung der Performance von Featured Snippets bei Google, doch laut Gary Illyes gibt es internen Widerstand gegen die Veröffentlichung

09:20: Es zeigt sich, dass das Erwähnen bestimmter Keywords wie "umleiten" auf Seiten über Redirects noch immer viel bringen kann...

09.17: Es gibt interessante Insights zur Migration von onpage.org auf ryte.com. Beeindruckendes Projekt...

09:12: Marcus Tanlder betrifft die Bühne. Thema: "Position Zero". 420 Folien warten auf uns......

09:07: Uschi und Oliver Hauser, die Gründer der SEOkomm stehen auf der Bühne

09:02: Und schon steht Tobias Fox auf der Bühne. Warum er immer so gut drauf ist? Das habe jedenfalls nichts mit Drogen zu tun ;-) Vielmehr seien es die vielen tollen SEOs, die für gute Laune sorgen :-)

09:00: Und los geht's. Dramatisches Intro, Wildwest-Sound im Stile von Ennio Morricone tönt durch den Saal.

08.50: In zehn Minuten startet die SEOkomm. Der Saal für Track 1 ist bereits gut gefüllt. Die Bühne ist bereit - schaut gemütlich aus:

Recaps zur SEOkomm 2017

SEO-Newsletter bestellen

Verwandte Beiträge

Recap SEOkomm 2013