Google: Vorsicht, in der robots.txt wird zwischen Groß- und Kleinschreibung unterschieden

Bei Regeln in der robots.txt unterscheidet Google zwischen Groß- und Kleinschreibung. Das kann zu unerwarteten Fehlern führen.

Bei Regeln in der robots.txt unterscheidet Google zwischen Groß- und Kleinschreibung. Das kann zu unerwarteten Fehlern führen.

Wenn bestimmte Seiten oder Pfade per robots.txt für Crawler gesperrt sind, aber dennoch in den Suchergebnissen auftauchen, kann es an einer fehlerhaften Groß- oder Kleinschreibung in der robots.txt liegen.

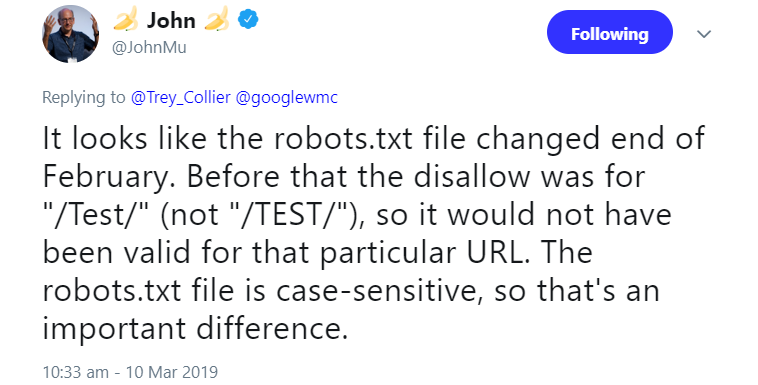

Das zeigt ein aktueller Fall: Ein Nutzer hatte bei Google angefragt, warum eine bestimmter Pfad mit dem Namen "/TEST/" seiner Website in der Google Search Console als gecrawlt angezeigt wurde, obwohl er ihn doch per robots.txt gesperrt habe.

Johannes Müller antwortete, die betreffende Regel in der robots.txt habe sich anscheinend kürzlich geändert. Bis vor kurzem habe sich die Regel auf den Pfad "/Test/" bezogen, erst danach lautete sie auf "/TEST/". Weil Groß- und Kleinschreibung in der robots.txt zählten, sei der betreffende Pfad gecrawlt worden:

Auf die Beachtung von Groß- und Kleinschreibung weist Google auch im Hilfedokument zum Erstellen von robots.txt-Dateien hin. Dort heißt es:

"Bei den Regeln muss die Groß- und Kleinschreibung beachtet werden. Beispielsweise ist Disallow: /file.asp auf http://www.example.com/file.asp anwendbar, jedoch nicht auf http://www.example.com/FILE.asp."

Titelbild: Copyright Patrick Daxenbichler - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

Google: URLs, die trotz robots.txt indexiert sind, fallen irgendwann aus dem Index