Google: Wenn das Crawlen den Webserver auslastet, ist nicht der Googlebot schuld

Wenn das Crawlen einer Website die Ressourcen des Webservers auslastet, dann ist die Verantwortung laut Google auf der Website zu suchen und nicht beim Googlebot.

Wenn das Crawlen einer Website die Ressourcen des Webservers auslastet, dann ist die Verantwortung laut Google auf der Website zu suchen und nicht beim Googlebot.

Gerade für größere Websites mit vielen Tausenden von Unterseiten kann das Crawlen ein Faktor für die Auslastung des Webservers sein. Damit alle wichtigen Seiten möglichst aktuell im Google-Index vertreten sind, ist es erforderlich, dass der Googlebot regelmäßig die Seiten abruft und auf Änderungen überprüft.

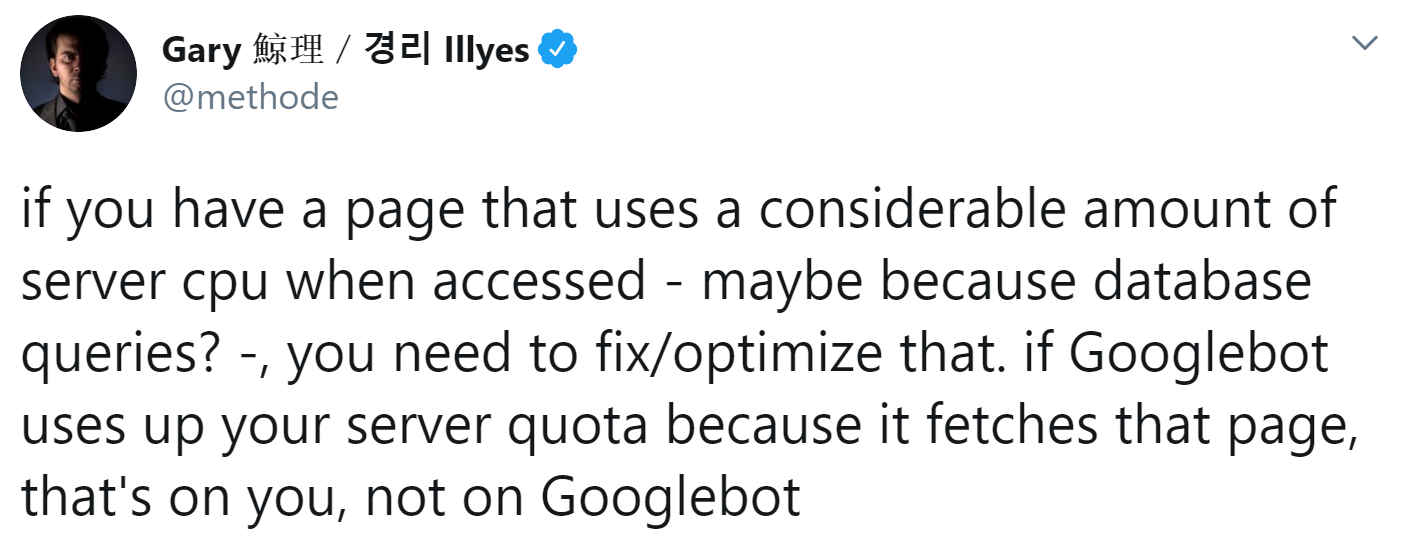

Wenn der Abruf dieser Seiten zu einer hohen Last auf dem Webserver führt, zum Beispiel, weil aufwändige Datenbankabfragen durchgeführt werden müssen, kann das Crawlen aller wichtigen Seiten den Webserver überlasten. In diesem Fall ist Verantwortung laut Google aber bei der Website zu suchen und nicht beim Googlebot. Das schrieb Gary Illyes jetzt auf Twitter:

Google erkennt Lastprobleme auf Webservern und reduziert dann automatisch die Crawling-Frequenz - insbesondere dann, wenn es zu einem erhöhten Aufkommen an 500er-Fehlern kommt.

Eine erste Übersicht über mögliche Probleme beim Crawlen liefern die Crawling-Statistiken in der Google Search Console. Dort findet man Angaben zur Zahl der pro Tag vom Googlebot abgerufenen Seiten, zum heruntergeladenen Datenvolumen sowie zur durchschnittlichen Downloadzeit. Auch auf den Bereich "Abdeckung" in der Search Console sollte man einen Blick werfen und prüfen, ob dort gehäuft 500er-Fehler vorkommen.

SEO-Newsletter bestellen

Verwandte Beiträge

Google: Diese HTTP-Statuscodes belasten das Crawl-Budget