Google: Ping einer Webseite an Google per robots.txt bringt nichts

Das Hinzufügen einer Webseite zur robots.txt mit dem Ziel, dass Google diese schneller crawlt, funktioniert nicht.

Das Hinzufügen einer Webseite zur robots.txt mit dem Ziel, dass Google diese schneller crawlt, funktioniert nicht.

Noch immer ist das Tool zum Einreichen von URLs zur Indexierung in der Google Search Console nicht verfügbar. Aus diesem Grund suchen manche Webmaster nach Alternativen, wie sie URLs schneller in den Index bekommen können.

Eine neue Idee dazu hat jetzt ein Nutzer auf Twitter geäußert: Er fragte, ob es möglich sei, eine Seite in der robots.txt anzugeben, um Google auf sie aufmerksam zu machen - in ähnlicher Weise funktioniert das mit einer XML-Sitemap. Gibt man die URL einer Sitemap in der robots.txt an, kann man Google damit auf die Datei aufmerksam machen und dafür sorgen, dass sie abgerufen wird.

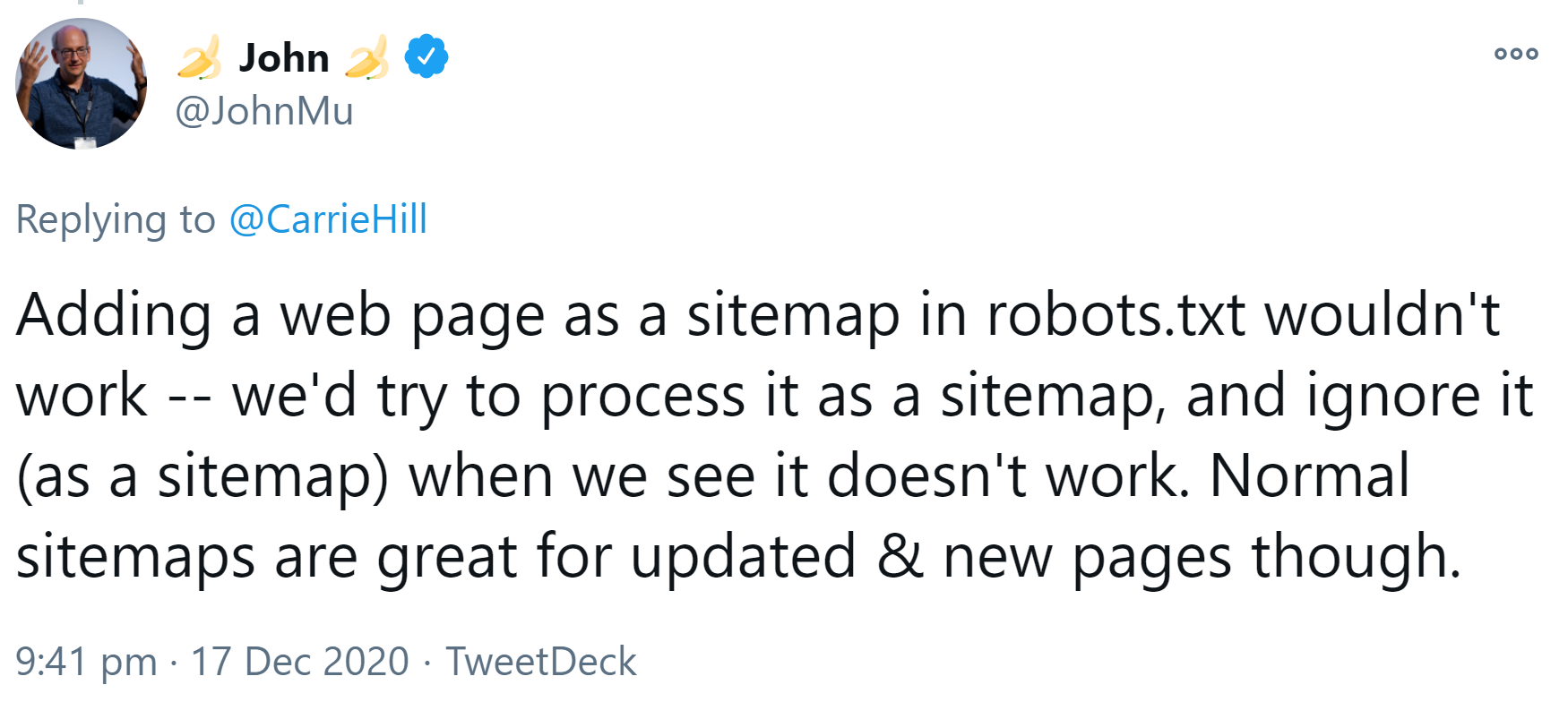

Mit Webseiten funktioniert ein solcher Ping allerdings nicht. Das erklärte John Müller per Twitter. Google würde versuchen, die eingereichte Seite als Sitemap zu behandeln und sie dann, wenn das nicht funktioniere, ignorieren:

"Adding a web page as a sitemap in robots.txt wouldn't work -- we'd try to process it as a sitemap, and ignore it (as a sitemap) when we see it doesn't work. Normal sitemaps are great for updated & new pages though."

Um Google auf eine neue URL aufmerksam zu machen, gibt es derzeit andere Möglichkeiten: Zum Beispiel das Nennen der URL in einer XML-Sitemap mit neuem Aktualisierungsdatum und eine möglichst prominente interne Verlinkung der betreffenden Seite.

Titelbild: Copyright teguhjatipras - stock.adobe.com

SEO-Newsletter bestellen

Verwandte Beiträge

Google: Wenn sich Sitemap ändert, dann auch lastmod in Sitemap-Index aktualisieren