Wenn Google das Crawlen erhöht, muss das nicht an einer besseren Qualitätsbewertung liegen

Wenn die Anzahl der von Google gecrawlten URLs einer Website plötzlich ansteigt, muss das nicht bedeuten, dass Google die Qualität der Website höher wertet. Es gibt viele Einflussfaktoren, die das Crawlen beeinflussen.

Wenn die Anzahl der von Google gecrawlten URLs einer Website plötzlich ansteigt, muss das nicht bedeuten, dass Google die Qualität der Website höher wertet. Es gibt viele Einflussfaktoren, die das Crawlen beeinflussen.

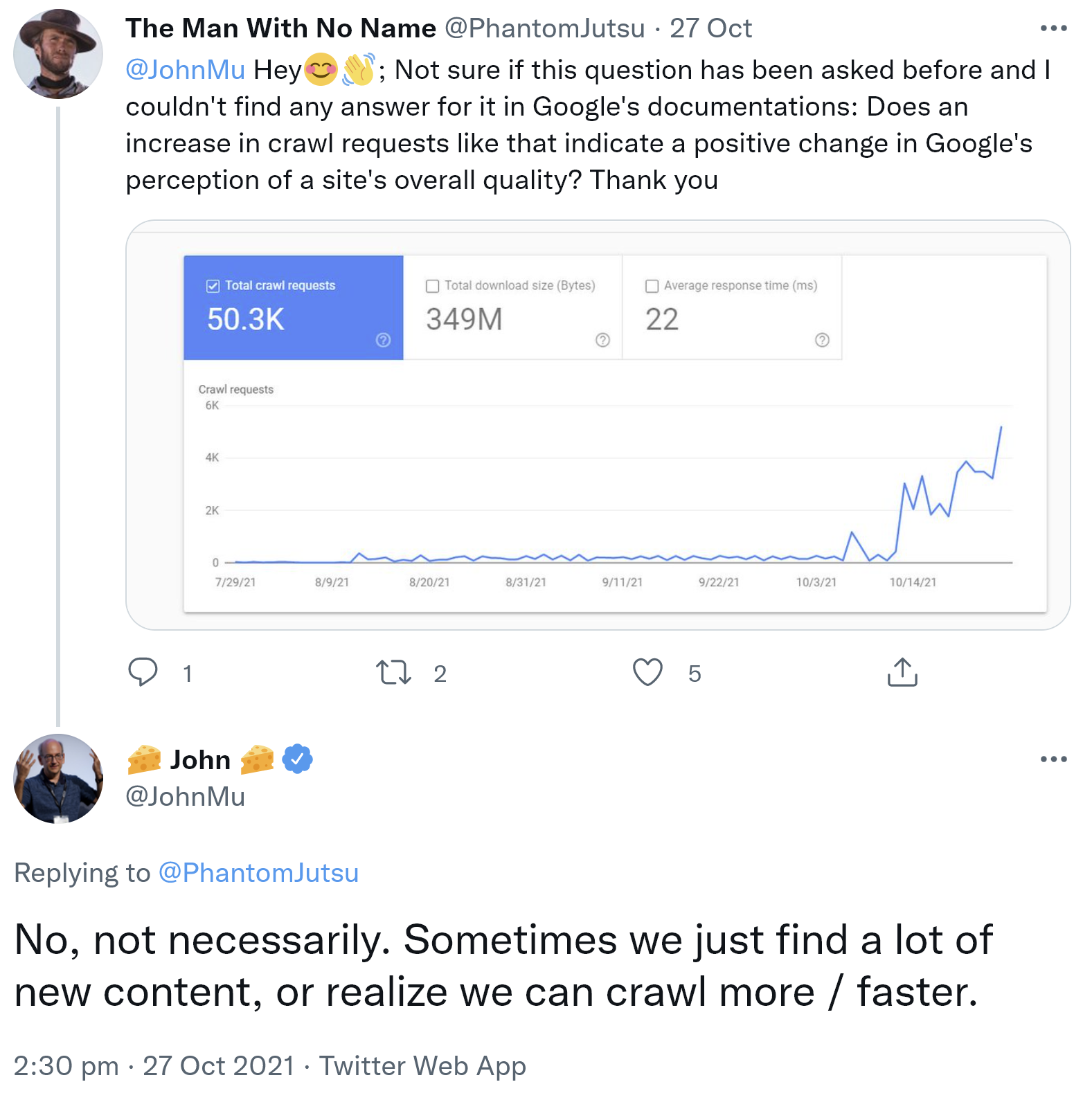

Was bedeutet es, wenn Google mehr URLs einer Website crawlt? Eines ist klar: Es kann dafür verschiedene Ursachen geben. Man darf daraus nicht einfach den Schluss ziehen, dass Google die Website höher bewertet. Das erklärte John Müller per Twitter als Antwort auf die Frage eines Nutzers, der einen Anstieg der Zahl gecrawlter URLs seiner Wesite festgestellt hatte. Der Nutzer wollte wissen, ob dies in Zusammenhang mit einer gestiegenen Qualitätsbewertung der Website insgesamt stehe.

John Müller schrieb, das müsse nicht so sein. Manchmal finde Google einfach viele neue Inhalte oder könne einfach mehr und schneller crawlen:

"No, not necessarily. Sometimes we just find a lot of new content, or realize we can crawl more / faster."

Wie viele URLs einer Website Google crawlt, wird von zwei Faktoren bestimmt: durch Begrenzungen der Crawl-Rate und durch den Crawl-Bedarf. Begrenzungen können sich zum Beispiel aus technischen Gründen ergeben, zum Beispiel, wenn der Server lange zum Antworten braucht, oder wenn es beim Crawlen zu vielen Fehlern kommt. Auch eine manuell per Google Search Console vorgenommene Begrenzung des Crawlens zählt dazu.

Der Crawl-Bedarf gibt an, wie viele URLs Google crawlen möchte. Umso mehr aktuelle Inhalte und umso relevanter die Inhalte einer Website sind, desto höher ist dieser Bedarf. Populäre URLs werden dabei häufiger gecrawlt, weil Google insbesondere bei diesen für einen aktuellen Index sorgen möchte.

Wenn es also zu Veränderungen der Anzahl gecrawlter URLs kommt, sollte man alle in Frage kommenden Faktoren untersuchen.

SEO-Newsletter bestellen

Verwandte Beiträge

Google: Diese HTTP-Statuscodes belasten das Crawl-Budget