John Müller von Google: 'Probleme mit DNS-Server verursachen normalerweise keine langanhaltenden Schäden.'

John Müller von Google hat sich zu den jüngsten Problemen mit dem Crawlen von Websites aufgrund von nicht erreichbaren DNS-Servern geäußert. Die wichtigste Botschaft: Langanhaltende Schäden sind aus SEO-Sicht unwahrscheinlich.

John Müller von Google hat sich zu den jüngsten Problemen mit dem Crawlen von Websites aufgrund von nicht erreichbaren DNS-Servern geäußert. Die wichtigste Botschaft: Langanhaltende Schäden sind aus SEO-Sicht unwahrscheinlich.

Vor dem Hintergrund der jüngsten Crawling-Probleme von Domains, die beim Hoster SiteGround liegen, hat John Müller von Google eine Reihe von Tweets verfasst, in denen es um die Auswirkungen von DNS-Problemem auf die Indexierung von Websites geht.

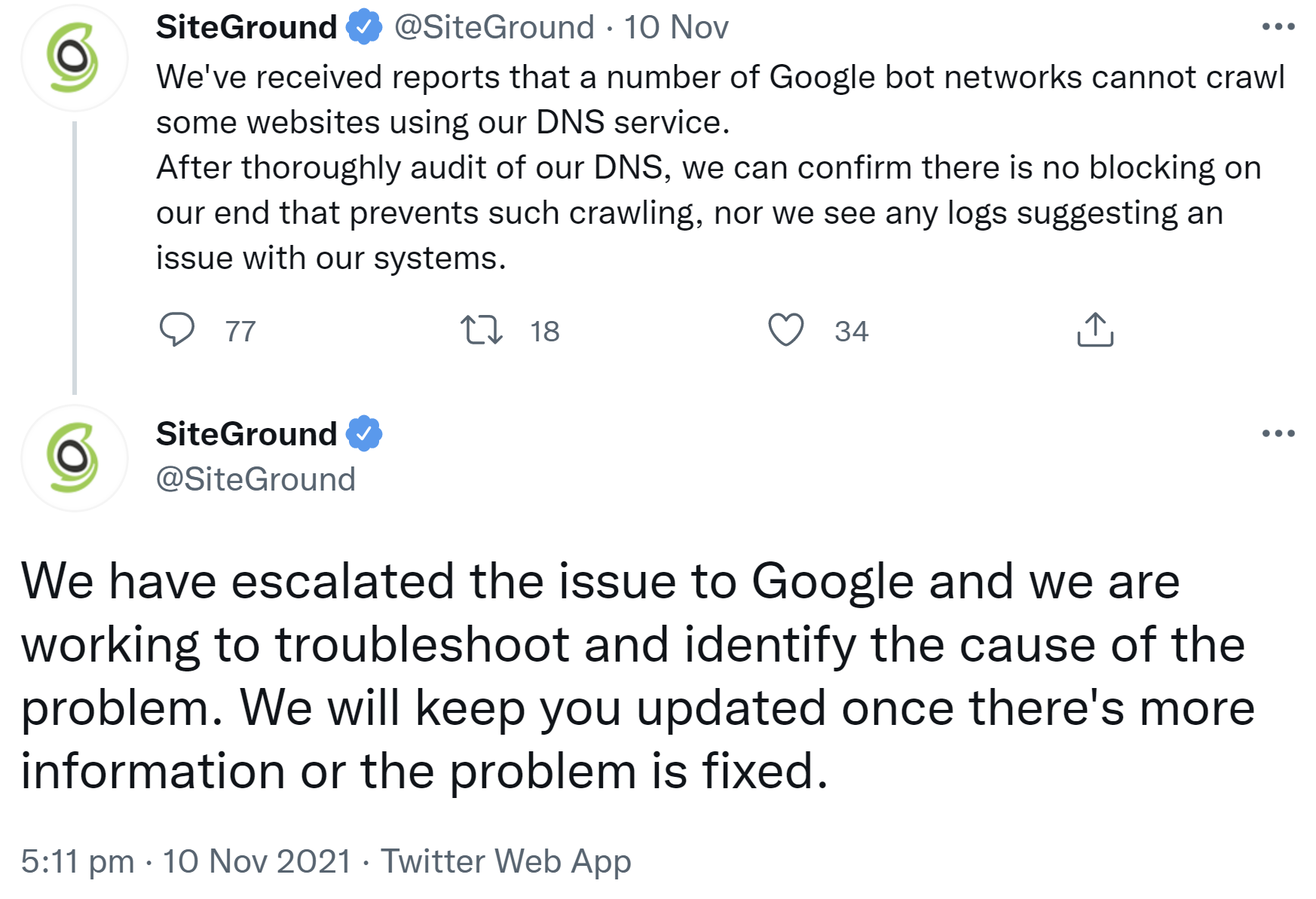

Im Lauf dieser Woche hatte Google Probleme, Websites des Hosters SiteGround zu crawlen. Der Hoster selbst schrieb dazu auf Twitter, man habe dies an Google eskaliert:

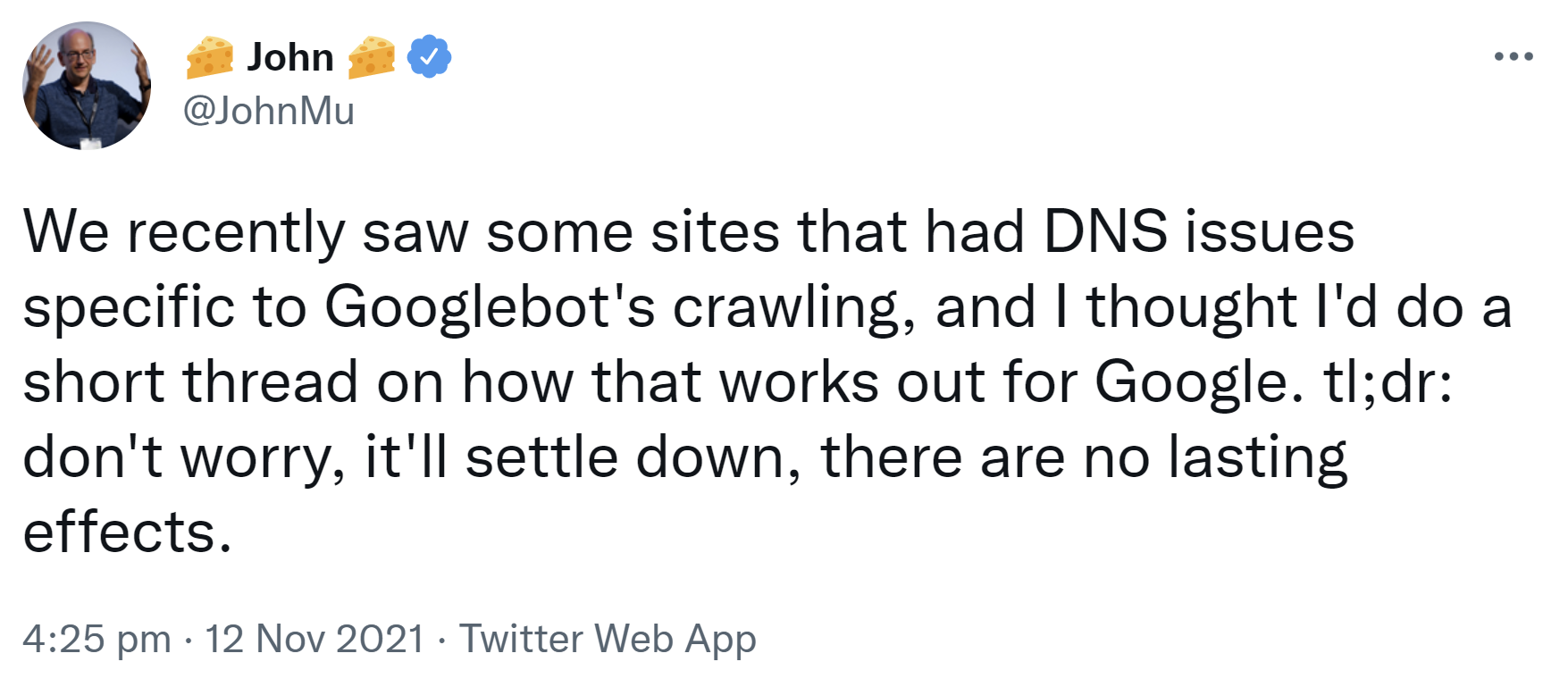

John Müller schrieb zunächst, solche DNS-Probleme würden keine nachhaltigen Effekte auf die Suche haben:

"We recently saw some sites that had DNS issues specific to Googlebot's crawling, and I thought I'd do a short thread on how that works out for Google. tl;dr: don't worry, it'll settle down, there are no lasting effects."

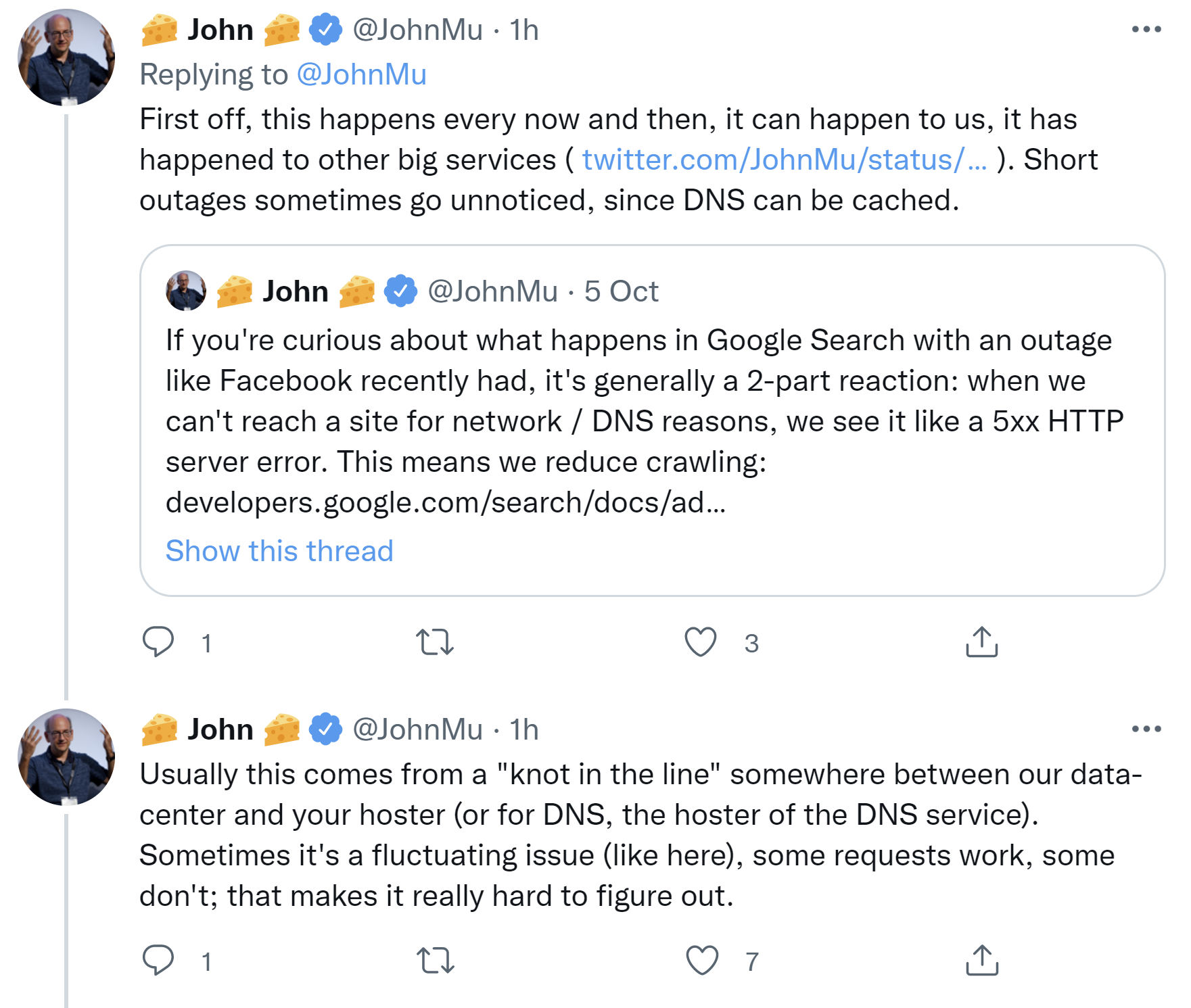

Müller schrieb weiter, DNS-Probleme können passieren. Er verwies auf ähnliche Probleme, die es bei Google schon gegeben hatte, sowie auf jüngste Schwierigkeiten dieser Art bei Facebook. Manche dieser Fehler würden gar nicht auffallen, weil DNS im Cache gespeichert werden kann. Es handele sich bei solchen Problemen um einen "Knoten in der Leitung" zwischen Googles Datencenter und dem Hoster der betroffenen Websites. Manchmal seien es fließende Probleme - so wie im aktuellen Fall. Manche Requests würden funktionieren, andere nicht. Das mache es so schwer, die Probleme zu erkennen:

Müller verwies in diesem Zusammenhang auf die kürzlich veröffentlichte Liste von IP-Adressen, die Google zum Crawlen verwendet und die man zum Beispiel zum Einrichten entsprechender Freigaben verwenden könne.

DNS-Probleme würden wie vorübergehende 500er-Fehler behandelt. Zunächst würde Google das Crawlen reduzieren. Nach etwa einem Tag würden die Probleme als fataler Fehler gewertet, was zur Deindexierung der Seiten führen könne, wenn Google die Seiten erneut crawle:

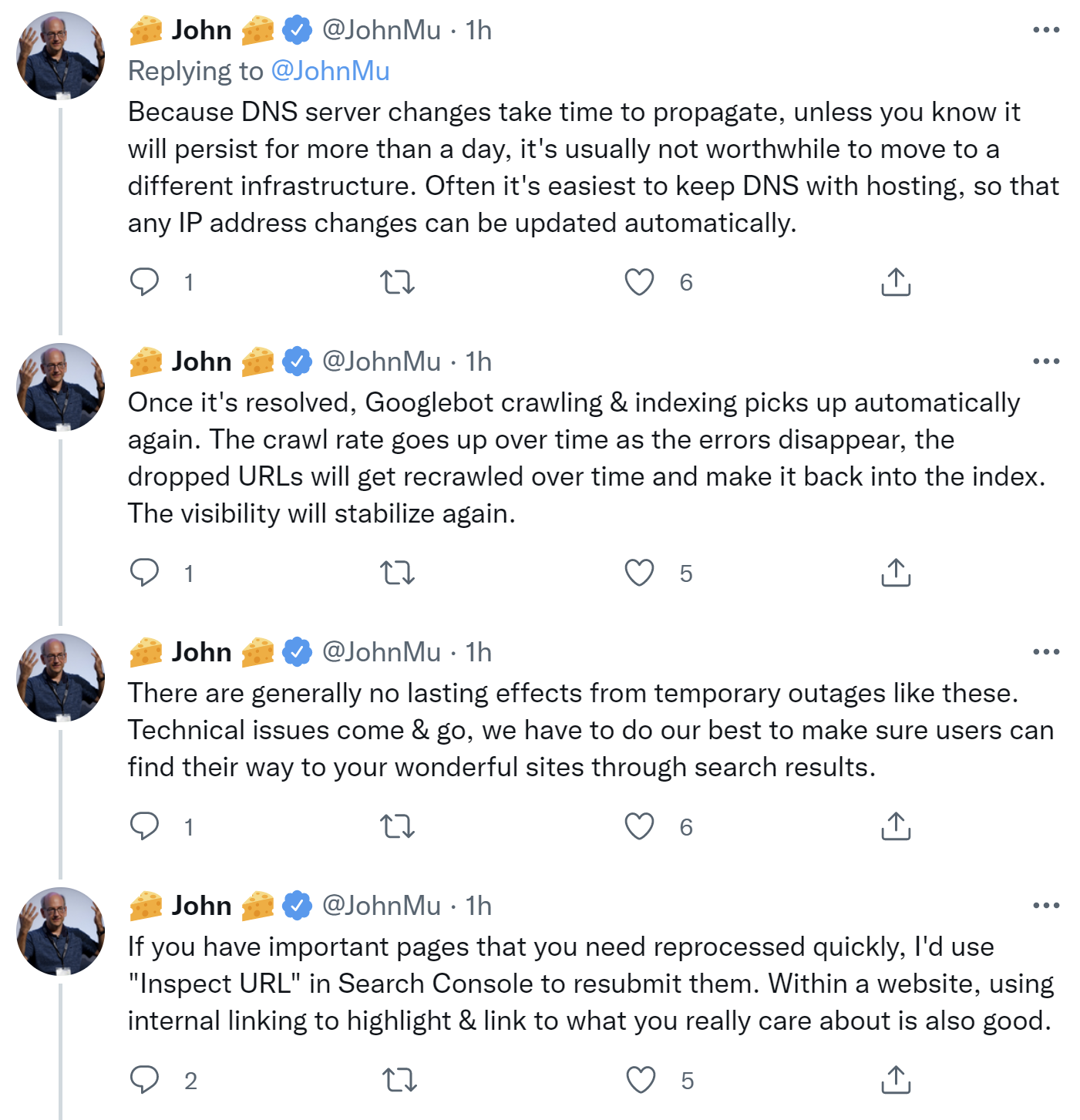

Es lohne sich nicht, wegen DNS-Problemen auf eine andere Infrastruktur zu wechseln, außer, man wisse, dass die Probleme länger als einen Tag andauern würden, so Müller weiter. Nachdem die Probleme behoben seien, würde Google das Crawlen wieder aufnehmen und die Seiten wieder indexieren. Langanhaltende Effekte seien nicht zu erwarten.

Für besonders wichtige Seiten empfahl Müller die Verwendung des URL Submission Tools zum Einreichen der URLs für die Indexierung:

Nach dem Beheben der Probleme werde die Fehleranzahl in der Google Search Console nicht sofort auf null sinken. Das liege an der Art, wie die Daten für die Search Console aggregiert werden.

Müller lobte außerdem die Hosting-Anbieter: Sie machten einen tollen Job, und er höre selten von Ausfällen:

Die ausführliche Aufklärung zu den zuletzt aufgetretenen DNS-Problemen wird sicherlich vielen Webmasterinnen und Webmastern eine gute Hilfe sein, wenn sie selbst einmal von ähnlichen Problemen betroffen sein werden.

Wichtig ist es, ruhig zu bleiben und nicht in Panik zu geraten. Und selbst wenn die eine oder andere Seite vorübergehend aus dem Index entfernt werden sollte, wird Google diese sehr wahrscheinlich anschließend wieder indexieren und ihren vorherigen Status wiederherstellen.

SEO-Newsletter bestellen

Verwandte Beiträge

Google: Neue Doku zu HTTP-Statuscodes und DNS-Fehlern erklärt Auswirkungen auf die Suche