Google: Auch nach dem Reduzieren der Crawl-Rate werden wichtige URLs weiter gecrawlt

Beim Reduzieren der Crawl-Rate per Google Search Console crawlt Google weiterhin die wichtigen URLs und lässt zunächst von weniger wichtigen URLs ab.

Beim Reduzieren der Crawl-Rate per Google Search Console crawlt Google weiterhin die wichtigen URLs und lässt zunächst von weniger wichtigen URLs ab.

In der Google Search Console gibt es ein Werkzeug, mit dem sich die Crawl-Rate für Websites reduzieren lässt. Das kann zum Beispiel im Falle technischer Probleme sinnvoll sein.

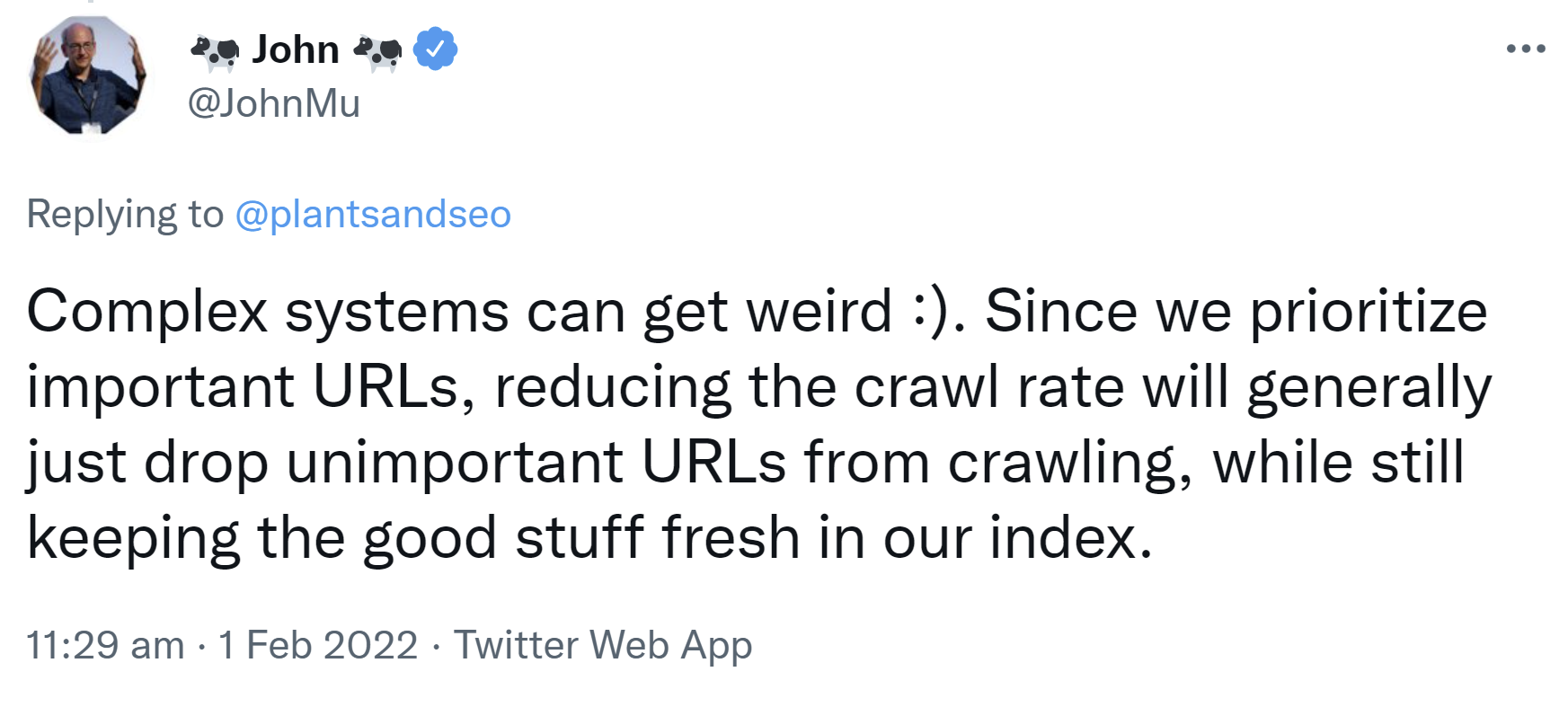

Reduziert man die Crawl-Rate, werden wichtige URLs weiterhin gecrawlt, während das Crawlen wichtiger URLs reduziert wird, Das erklärte John Müller per Twitter. Die guten Inhalte sollen dadurch im Index aktuell gehalten werden.

"Complex systems can get weird :). Since we prioritize important URLs, reducing the crawl rate will generally just drop unimportant URLs from crawling, while still keeping the good stuff fresh in our index."

Müllers Antwort bezog sich auf eine Anfrage, in der es darum ging, dass für eine Website plötzlich sehr viele URLs mit Query-Parameter gecrawlt wurden. So etwas kann passieren, wenn auf einer Website eine Suchefunktion angeboten wird und die internen Suchergebnisseiten mit einem solchen Parameter ausgespielt werden.

Möchte man das Crawlen dieser und ähnlicher unwichtiger URLs reduzieren, gibt es die Möglichkeit, dies per robots.txt zu unterbinden, oder eben die Crawl-Rate per Search Console zu reduzieren, was allerdings nur als kurzfristige Übergangslösung gelten sollte.

SEO-Newsletter bestellen

Verwandte Beiträge

GPTBot auf Platz 3 der meistgenutzten Crawler, Google nach wie vor Nummer 1