Google: Es ist ok, Nutzern mehr Inhalte zu zeigen als dem Googlebot

Es kann Situationen geben, in denen es sinnvoll ist, wenn bestimmte Besucher einer Webseite mehr Informationen zu sehen bekommen als Besucher aus der organischen Suche oder der Googlebot. Für Google ist das grundsätzlich in Ordnung.

Es kann Situationen geben, in denen es sinnvoll ist, wenn bestimmte Besucher einer Webseite mehr Informationen zu sehen bekommen als Besucher aus der organischen Suche oder der Googlebot. Für Google ist das grundsätzlich in Ordnung.

Normalerweise gilt der Grundsatz: Der Googlebot sollte dieselben Informationen auf einer Webseite finden wie die Besucher der Webseite. Abweichungen können sich negativ auf die Rankings auswirken - insbesondere dann, wenn die Unterschiede so groß sind, dass dies als Cloaking gewertet wird.

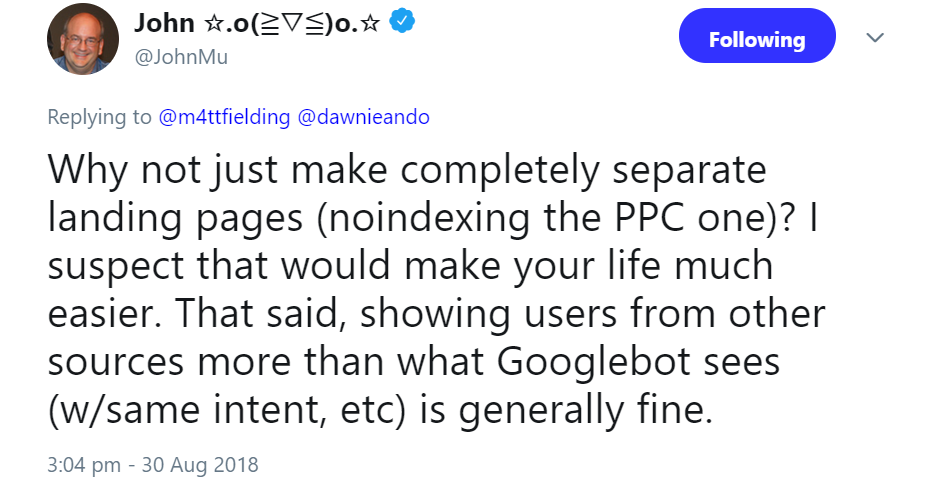

Es kann aber Situationen geben, in denen eine Variantion der Inhalte sinnvoll und auch für Google in Ordnung ist. Ein solcher Fall wurde gerade auf Twitter diskutiert. Es ging dabei um eine Seite, die, je nachdem, woher die Besucher kommen, mehr oder weniger Informationen enthält. Nutzer, die über einen Klick auf eine AdWords-Anzeige auf die Seite kommen, erhalten gegenüber Besuchern aus der organischen Suche zusätzliche Informationen. Dies sei laut Betreiber wichtig, weil sich das Verhalten und das Informationsbedürfnis der Nutzergruppen unterscheide. Der Betreiber der Webseite wollte wissen, ob dies für Google grundsätzlich in Ordnung sei.

Johannes Müller machte den Vorschlag, für die Anzeigenkunden eine separate Landing Page zu erstellen und diese auf "noindex" zu setzen. Es sei aber grundsätzlich in Ordnung, Nutzern aus anderen Quellen andere Informationen anzuzeigen als dem Googlebot, wenn die Grundaussage gleich sei.

Wichtig ist in solchen Fällen tatsächlich, sich zunächst Gedanken über das Informationsbedürfnis der Nutzer zu machen und dann die Landing Pages entsprechend zu gestalten. In vielen Fällen kann es sinnvoll sein, die Landing Page für AdWords-Besucher anders zu gestalten als die Landing Page für organische Nutzer. In solchen Fällen muss aber darauf geachtet werden, die AdWords Landing Page auf "noindex" zu stellen.

SEO-Newsletter bestellen

Verwandte Beiträge

GPTBot auf Platz 3 der meistgenutzten Crawler, Google nach wie vor Nummer 1