Google kann grundsätzlich auch Datenbanken crawlen

Google ist in der Lage, Datenbanken zu crawlen, wenn deren Inhalte in Form von Form von Webseiten mit validen URLs ausgegeben werden. Das ist auch mit Blick auf das Web 3.0 interessant.

Das Web 3.0 zeichnet sich vor allem durch eine verstärkte Dezentralisierung aus. Den Endpunkten im Netz kommt eine größere Bedeutung zu, weil Aufgaben dort und nicht mehr auf zentralen Servern stattfinden.

Ein Begriff, der im Zusammenhang mit dem Web 3.0 immer wieder fällt, ist Ethereum. Dabei handelt es sich um ein dezenrales und erlaubnisloses Netzwerk. Es basiert auf der Blockchain. Per Ethereum können sogenannte Decentralized Applications ausgeführt werden, zum Beispiel in Verbindung mit dem Finanzwesen.

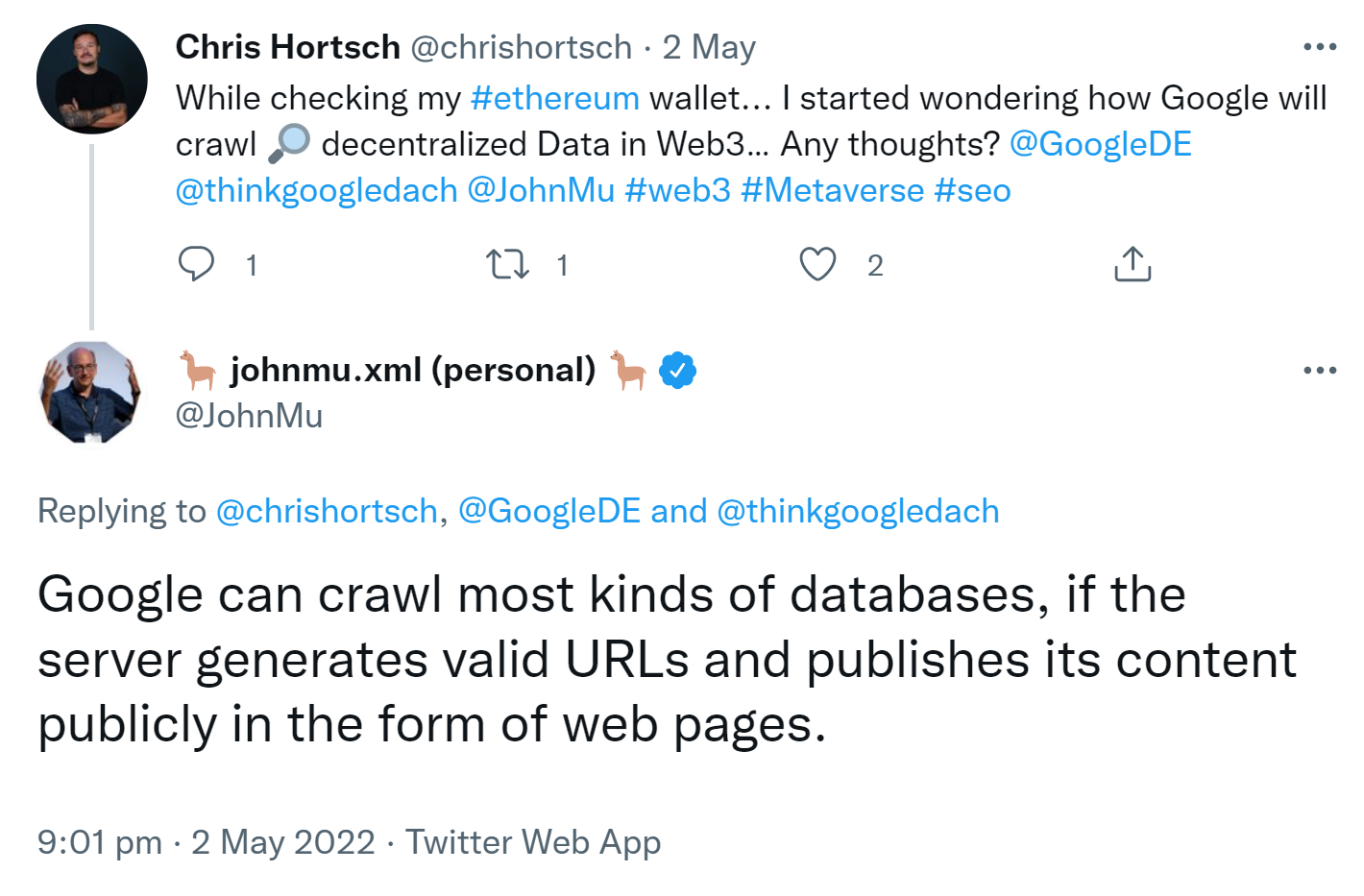

Im Zusammenhang mit Ethereum wurde jetzt die grundsätzliche Frage an John Müller gestellt, wie Google in einem dezentralen Web Daten crawlen wird.

John Müller antwortete darauf, Google könne die meisten Arten von Datenbanken crawlen, sofern die Daten in Form von Webseiten über valide URLs erreichbar seien:

"Google can crawl most kinds of databases, if the server generates valid URLs and publishes its content publicly in the form of web pages."

Letztendlich trifft diese Antwort auf die meisten Arten von Websites zu, denn ein großer Teil der Inhalte für die Anzeige der Seiten stammen bei Content Management Systemen wie WordPress aus Datenbanken und werden beim Abruf zu HTML-Seiten zusammengefügt.

Es beantwortet die gestellte Frage allerdings nicht oder zumindest nicht vollständig. Gerade der Verzicht auf zentrale Webserver zeichnet das Web 3.0 aus. Es wäre in der Tat interessant zu wissen, wie Google konkret mit dezentralen Daten umgehen wird.

In diesem Zusammenhang hatte John Müller zuletzt immerhin geschrieben, Web 3.0 bedeute nicht das Aus von SEO.

SEO-Newsletter bestellen

Verwandte Beiträge