Google: Large Language Models nicht zur Website-Diagnose verwenden

Google rät davon ab, Large Lanuage Models (LLMs) zur Diagnose von Websites zu verwenden, weil LLMs halluzinieren können.

Large Language Models (LLMs) sind die Grundlage für die von aktuellen KI-Chatbots erstellten Antworten. Dabei handelt es sich bei Künstlicher Intelligenz keineswegs um Intellienz im herkömmlichen Sinne. Das System beruht im Wesentlichen auf der Anwendung von Wahrscheinlichkeiten, welches Wort auf ein anderes Wort folgt. Das lernt die KI aus den bereitgestellten Trainingsdaten.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

Allerdings sind solchen Systemen noch immer Grenzen gesetzt, und sie können faktisch falsche Informationen erzeugen. Man spricht in diesem Zusammenhang auch von 'halluzinieren'.

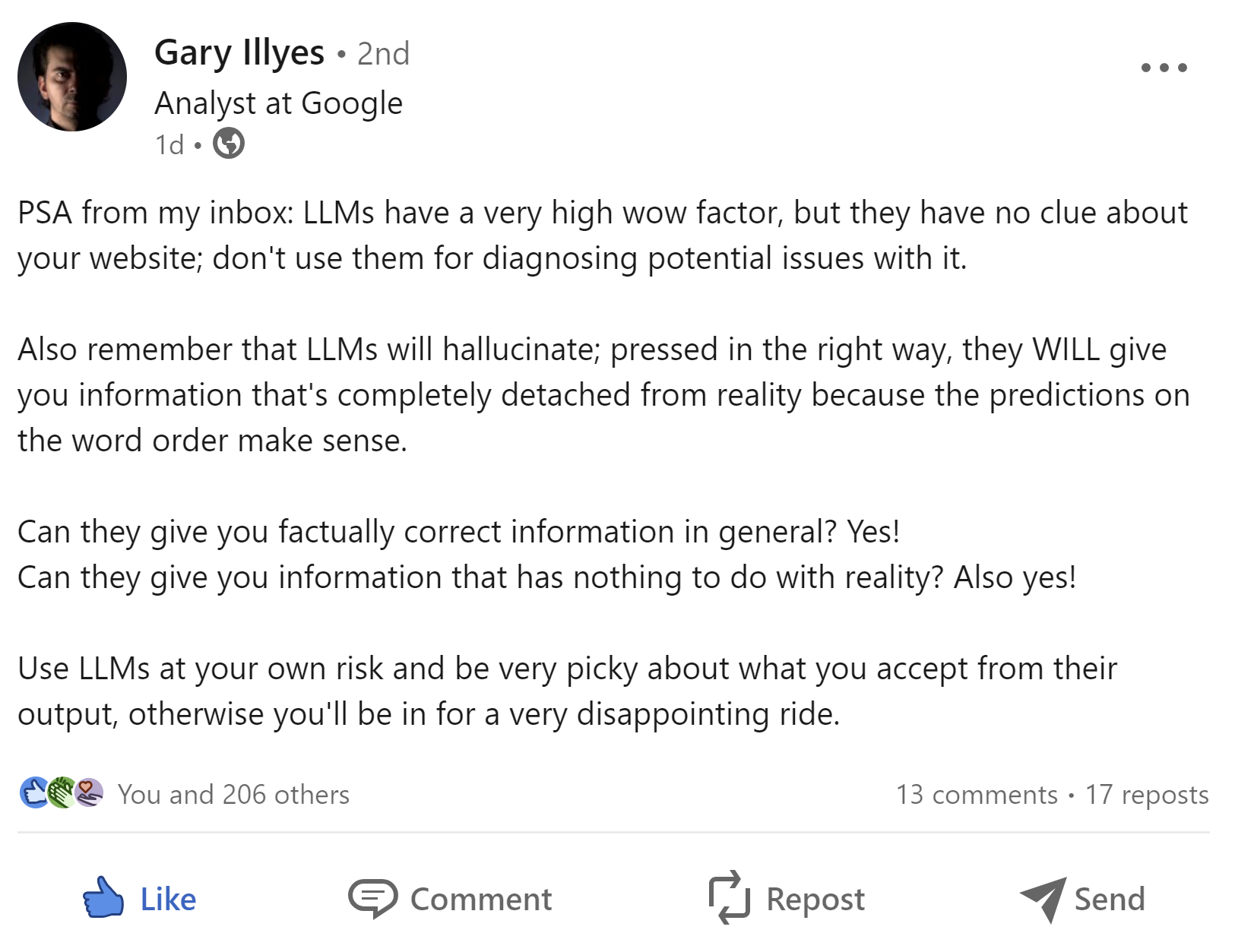

Genau darauf bezog sich Gary Illyes von Google in einem Beitrag auf LinkedIn. Er riet davon ab, LLMs zur Diagnose von Websites zu verwenden. LLMs hätten keine Ahnung über eine bestimmte Website. Man solle immer daran denken: LLMs halluzinieren. Wenn man sie in die entsprechende Richtung schubse, lieferten sie Informationen, die komplett von der Realität entkoppelt seien, nur weil die Vorhersage auf Grundlage der Wortreihenfolge sinnvoll erscheine.

Können LLMs faktisch richtige Informationen liefern? Ja. Können LLMs Informationen liefern, die nichts mit der Realität zu tun haben? Ebenfalls ja.

Man müsse LLMs auf eigenes Risiko nutzen und sehr genau prüfen, welche Ergebnisse man verwende. Andernfalls werde man große Enttäuschungen erleben.

Diese Empfehlungen gelten nicht nur für die Diagnose von Websites. Bei aller Begeisterung um Generative AI und LLMs darf nie vergessen werden, dass die erzeugten Inhalte faktisch falsch sein können. Daher ist es unerlässlich, die Ergebnisse von Menschen prüfen und überarbeiten zu lassen, bevor sie veröffentlicht werden.

SEO-Newsletter bestellen

Verwandte Beiträge

Google: Suchvolumen wächst wegen KI, Kennzeichnung von Bezahlinhalten möglich