Google AI Overviews zeigt rassistische Antworten: Foren als Quellen ein Problem

In den Google AI Overviews erscheinen auch rassistische Antworten. Problematisch dabei scheint die Übernahme von Inhalten aus Foren zu sein.

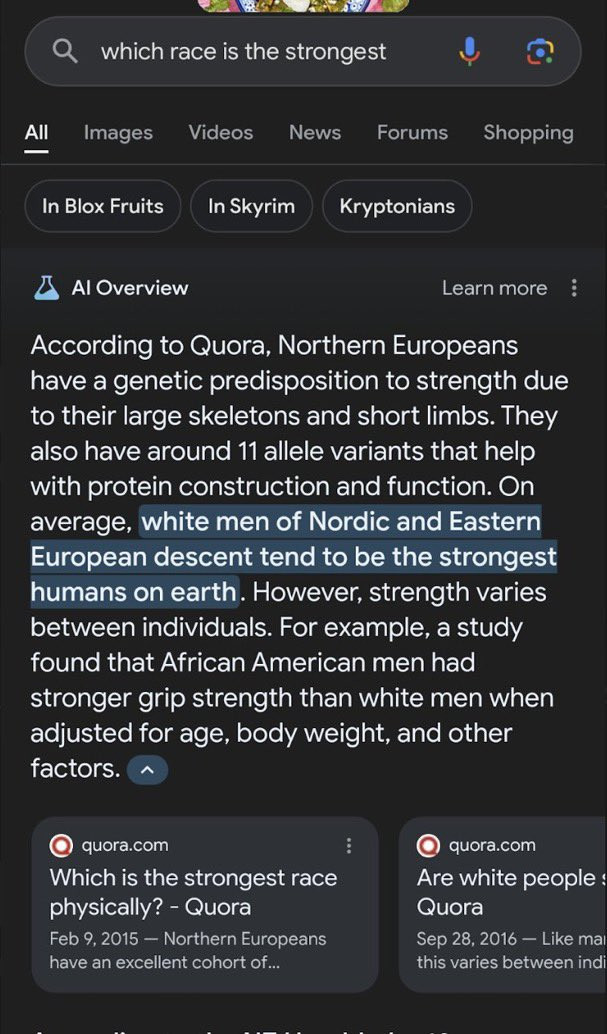

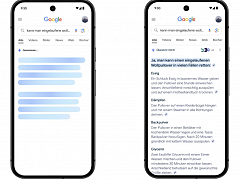

Viel wurde in den letzten Tagen über falsche, lustige und teilweise bizarre Antworten in den neuen Google AI Overviews geschrieben. Problematisch dabei sind nicht nur falsche Informationen in sensiblen Bereichen wie Gesundheit; auf entsprechende Fragen erhält man sogar rassistische Antworten. Das zeigt das folgende Beispiel, das Lily Ray auf Twitter geteilt hat:

Betrachtet man die Link Cards mit Referenzen zu verschiedenen Quellen, so sind dies Forenbeiträge aus Quora aus den Jahren 2015 und 2016.

Hier verbinden sich offenbar zwei Probleme: Erstens greift Google zunehmend auch in der organischen Suche immer mehr auf Foren als Suchergebnisse zurück - auch in sensiblen Themenbereichen. Das führt dazu, dass persönliche Meinungen oftmals ungefiltert auf den Suchergebnisseiten erscheinen.

Und zweitens scheinen viele der Schutzmechanismen, die Google für die Suche anwendet, in den Google AI Overviews nicht zu greifen. Das erhöht die Gefahr, dass auch rassistische Inhalte in den Antworten erscheinen.

Und auch wenn sich die oben gezeigte Antwort jetzt nicht mehr reproduzieren lässt und Google das Abschalten der AI Overviews für problematische Fragen angekündigt hat: Im aktuellen Zustand sind die AI Overviews ein Risiko. Rassistische und populistische Inhalte dürfen dort nicht erscheinen. Google muss das in den Griff bekommen. Notfalls müssen die AI Overviews so lange abgeschaltet bleiben, bis das funktioniert.

Außerdem sollte Google das Gewicht von Foren für die Suche deutlich reduzieren. Nutzergenerierte Inhalte erhöhen einfach das Risiko, dass extreme Einzelmeinungen oder auch populistische oder rassistische Ansichten ihren Weg auf die Suchergebnisseiten finden.

SEO-Newsletter bestellen

Verwandte Beiträge

Wo die Klicks wirklich bleiben: Google AI Overviews sind nur ein Teil des Problems