Google: SMITH-Algorithmus übertrifft BERT bei längeren Texten

SMITH ist ein neuer Algorithmus, der Google beim Verstehen längerer Texte helfen könnte. Damit übertrifft er BERT, dessen Fokus sich auf einzelne Sätze beschränkt.

SMITH ist ein neuer Algorithmus, der Google beim Verstehen längerer Texte helfen könnte. Damit übertrifft er BERT, dessen Fokus sich auf einzelne Sätze beschränkt.

Ein neuer Algorithmus könnte in nächster Zeit auch in der Suche von Google von sich reden machen. Gemeint ist SMITH. Die Abkürzung steht für "Siamese Multi-depth Transformer-based Hierarchical Encoder for Long-Form Document Matching". In einem wissenschaftlichen Beitrag werden die Aufgaben und die Funktionsweise von SMITH beschrieben.

Wie der bereits von Google eingesetzte BERT-Algorithmus dient auch SMITH dem Verstehen von Dokumenten und Suchanfragen. Der wohl wichtigste Unterschied zwischen BERT und SMITH besteht darin, dass BERT auf kürzere Textstellen wie einzelne Sätze oder einen Absatz ausgerichtet ist. SMITH hingegen soll dem Abgleich längerer Dokumente dienen:

"In recent years, self-attention based models like Transformers and BERT have achieved state-of-the-art performance in the task of text matching. These models, however, are still limited to short text like a few sentences or one paragraph due to the quadratic computational complexity of self-attention with respect to input text length. In this paper, we address the issue by proposing the Siamese Multi-depth Transformer-based Hierarchical (SMITH) Encoder for long-form document matching."

Bei SMITH geht es also um das Verstehen kompletter Absätze im Kontext längerer Texte. Mit SMITH wäre Google in der Lage, komplette Webseiten und längere Suchanfragen besser miteinander abzugleichen. Mithilfe von SMITH erhöht sich die Höchstmenge der Zeichen für den Input-Text von 512 auf 2048 Zeichen:

"Comparing to BERT based baselines, our model is able to increase maximum input text length from 512 to 2048."

Gerade der Vergleich zwischen langen Texten stellt eine große Herausforderung dar. Dafür nennen die Autorinnen und Autoren des Papiers die folgenden Gründe:

- Wenn beide zu vergleichenden Texte lang sind, dann setzt dies ein besseres Verständnis der semantischen Beziehungen inklusive Matching-Muster zwischen auch weiter voneinander entfernten Textfragmenten voraus.

- Lange Dokumente verfügen über eine bestimmte Struktur. Dazu gehören Abschnitte, Sätze und Absätze. Während menschliche Leserinnen und Leser diese Struktur verwenden können, muss diese Fähigkeit auch dem Modell zuteil werden, um eine bessere Leistung beim Abgleich der Dokumente erreichen zu können.

- Der Vergleich längerer Texte stellt größere Anforderungen an das Speichermanagement.

"1) When both texts are long, matching them requires a more thorough understanding of semantic relations including matching pattern between text fragments with long distance; 2) Long documents contain internal structure like sections, passages and sentences. For human readers, document structure usually plays a key role for content understanding. Similarly, a model also needs to take document structure information into account for better document matching performance; 3) The processing of long texts is more likely to trigger practical issues like out of TPU/GPU memories without careful model design."

Für den Abgleich längerer Texte gibt es verschiedene Anwendungsfälle. Dazu gehören zum Beispiel das Empfehlen von News, verwandten Artikeln oder das Clustern von Dokumenten. Gleichwohl räumen die Autoren ein, dass dieser Bereich bisher erst wenig erforscht sei:

"To the best of our knowledge, semantic matching between long document pairs, which has many important applications like news recommendation, related article recommendation and document clustering, is less explored and needs more research effort."

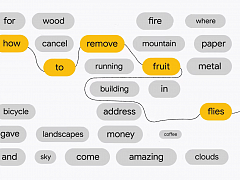

Pre-Training wie bei BERT

Wichtiger Bestandteil von SMITH ist ein "Pre-Training und Finetuning"-Paradigma, das auch bei BERT gegeben ist. Dabei erfolgt ein Pre-Training auf Basis eines umfangreichen und nicht gelabelten Textes mit nicht überwachtem Lernen. Beim Pre-Training werden bestimmte Wörter in einzelnen Sätzen maskiert. Der Algorithmus muss dann versuchen, die verdeckten Wörter zu ermitteln:

"For the Smith model pre-training, we propose the masked sentence block language modeling task in addition to the original masked word language modeling task used in BERT for long text inputs."

Bei langen Texten können zum Textverständnis sowohl die Beziehungen zwischen einzelnen Wörtern in einem Satz oder Absatz sowie die Beziehungen zwischen Sätzen oder Absätzen wichtig sein. Aus diesem Grund werden im Pre-Training sowohl einzelne Wörter als auch Satzblöcke auf Zufallsbasis maskiert:

"When the input text becomes long, both relations between words in a sentence block and relations between sentence blocks within a document becomes important for content understanding."

"Therefore, we mask both randomly selected words and sentence blocks during model pre-training."

Im Gegensatz zu BERT sollen auf diese Weise die Beziehungen zwischen Absätzen besser verstanden werden.

Das Finetuning findet mit einem überwachten Downstream-Task statt. Dadurch müssen zu Beginn nur weniger Parameter gelernt werden:

"For the model training of SMITH, we adopt the “pre-training + fine-tuning” paradigm as in BERT. This approach is to firstly pretrain the model with large unlabeled plain text in an unsupervised learning fashion, and then fine-tune the model with a supervised downstream task so that only few parameters need to be learned from scratch."

Hierarchisches Modell

Das Modell von SMITH sieht verschiedene Schichten vor: Auf der obersten Ebene befindet sich der Document Encoder, gefolgt von mehreren Ebenen, welche hierarchisch die einzelnen Texteinheiten verarbeiten. Auf der untersten Ebene befinden sich die Positionen und die Token.

Ein Dokument wird in mehrere Sätzblöcke zerlegt, von denen jeder einen oder mehrere natürliche Sätze enthalten kann. Die Blöcke haben eine vorgegebenen Länge. Wenn ein Satz nicht mehr in einen Block passt, wird er in den nächsten Block verschoben. Ist ein Satz länger als die Höchstlänge eines Blocks, so wird er abgeschnitten, damit er in den Block passt.

"Specifically, we split a document into multiple sentence blocks of predefined length so that each sentence block can contain one or more natural sentences. We try to fill as many sentences as possible into one sentence block until the block reaches the predefined max block length. When the last sentence cannot fill in the current block, we move it to the next block. When an individual sentence alone is longer than the max sentence block length, we truncate it to fit in the current block."

Ergebnisse

Die Autorinnen und Autoren kommen zum Schluss, dass SMITH im Vergleich zu vergleichbaren Modellen eine bessere Leistung erbringt, wenn es um den Abgleich längerer Dokumente geht:

"We can find that in general SMITH-WP+SP will achieve better performance as the maximum document length increases. This confirms the necessity of long text content modeling for document matching. The SMITH model which enjoys longer input text lengths compared with other standard self-attention models is a better choice for long document representation learning and matching."

Dazu gehören auch vorherige State-of-the-Art Siamese Matchig-Modelle wie HAN, SMASH und BERT:

"The experimental results on several benchmark datasets show that our proposed SMITH model outperforms previous state-of-the-art Siamese matching models including HAN, SMASH and BERT for long-form document matching. Moreover, our proposed model increases the maximum input text length from 512 to 2048 when compared with BERT-based baseline methods."

Verwendet Google SMITH bereits?

Aus der wissenschaftlichen Arbeit geht nicht hervor, ob Google SMITH bereits für die Suche verwendet. Eine offizielle Bestätigung dazu auch an anderer Stelle gibt es noch nicht. Den Einsatz von BERT hatte Google dagegen kommuniziert.

Denkbar ist eine Verwendung von SMITH im Zusammenhang mit dem von Google angekündigten Passage Based Indexing. Dies soll Google die gezieltere Indexierung von Abschnitten auf längeren Seiten ermöglichen. Das klingt durchaus nach einem möglichen Einsatzgebiet für SMITH.

Welche Auswirkungen von SMITH auf die SEO könnte es geben?

Ob und welche Konsequenzen sich aus SMITH für die SEO ergeben könnten, ist noch nicht zu beurteilen. Vergleicht man SMITH allerdings mit BERT, so dürften die sich daraus ableitbaren Handlungsempfehlungen sehr gering sein. Wenn Google längere Dokumente besser verstehen und auch längere Suchanfragen mit den Dokumenten abgleichen kann, so dürfte dies vor allem die Qualität der Suchergebnisse verbessern.

Betreiberinnen und Betreiber von Websites sollten weiterhin darauf achten, hochwertige, relevante und auch gut strukturierte Inhalte zu erstellen, und das mit Blick auf die Nutzer und nicht auf die Suchmaschinen. In diesem Fall werden sie auch von besseren Algorithmen wie SMITH profitieren können.

Danke an Search Engine Journal

SEO-Newsletter bestellen

Verwandte Beiträge

Neues Google-Video erklärt Spracherkennung durch BERT