Das nächste heiße SEO-Thema? Google LaMDA und MUM

Google hat auf der I/O ein neues Modell zum Verstehen natürlicher Sprache vorgestellt, das auch für die Suche zum Einsatz kommen soll. Google LaMDA ermöglicht offene Konversationen über beliebige Themen. MUM soll dabei helfen, Informationen aus verschiedenen Sprachen miteinander zu verknüpfen und in die Suche zu bringen.

Google hat auf der I/O ein neues Modell zum Verstehen natürlicher Sprache vorgestellt, das auch für die Suche zum Einsatz kommen soll. Google LaMDA ermöglicht offene Konversationen über beliebige Themen. MUM soll dabei helfen, Informationen aus verschiedenen Sprachen miteinander zu verknüpfen und in die Suche zu bringen.

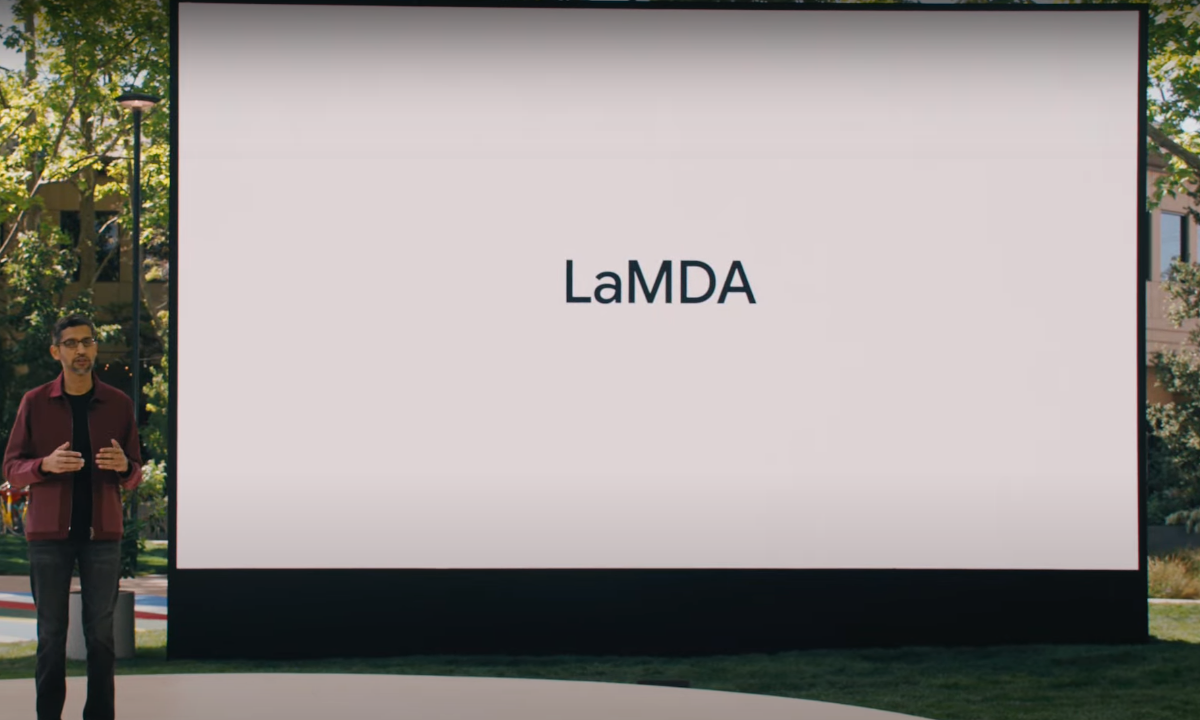

Auf der diesjährigen Google I/O wurde bereits in der Keynote von Sundar Pichai eine Neuheit präsentiert, die auch für die Suche und SEO Auswirkungen haben könnte und mit ziemlicher Sicherheit zu vielen Diskussionen unter SEOs führen wird. Es geht um ein neues Modell zum Erkennen natürlicher Sprache (Natural Language Understanding). Der Name des Modells lautet LaMDA. Die Abkürzung steht für "Language Model for Dialogue Applications".

LaMDA, das sich laut Pichai noch in der Entwicklung befindet, ermöglicht offene Konversationen in unbegrenzter Weise. Dabei werden Konzepte und Zusammenhänge über Entitäten wie zum Beispiel über die im All herrschende Kälte verwendet, auf die das System zugreifen kann. Auf diese Weise ist es zum Beispiel möglich, ein Gespräch mit einem Planeten oder mit einem Papierflugzeug zu führen, wobei das Modell in seinen Antworten auf bestehendes Wissen zugreifen kann.

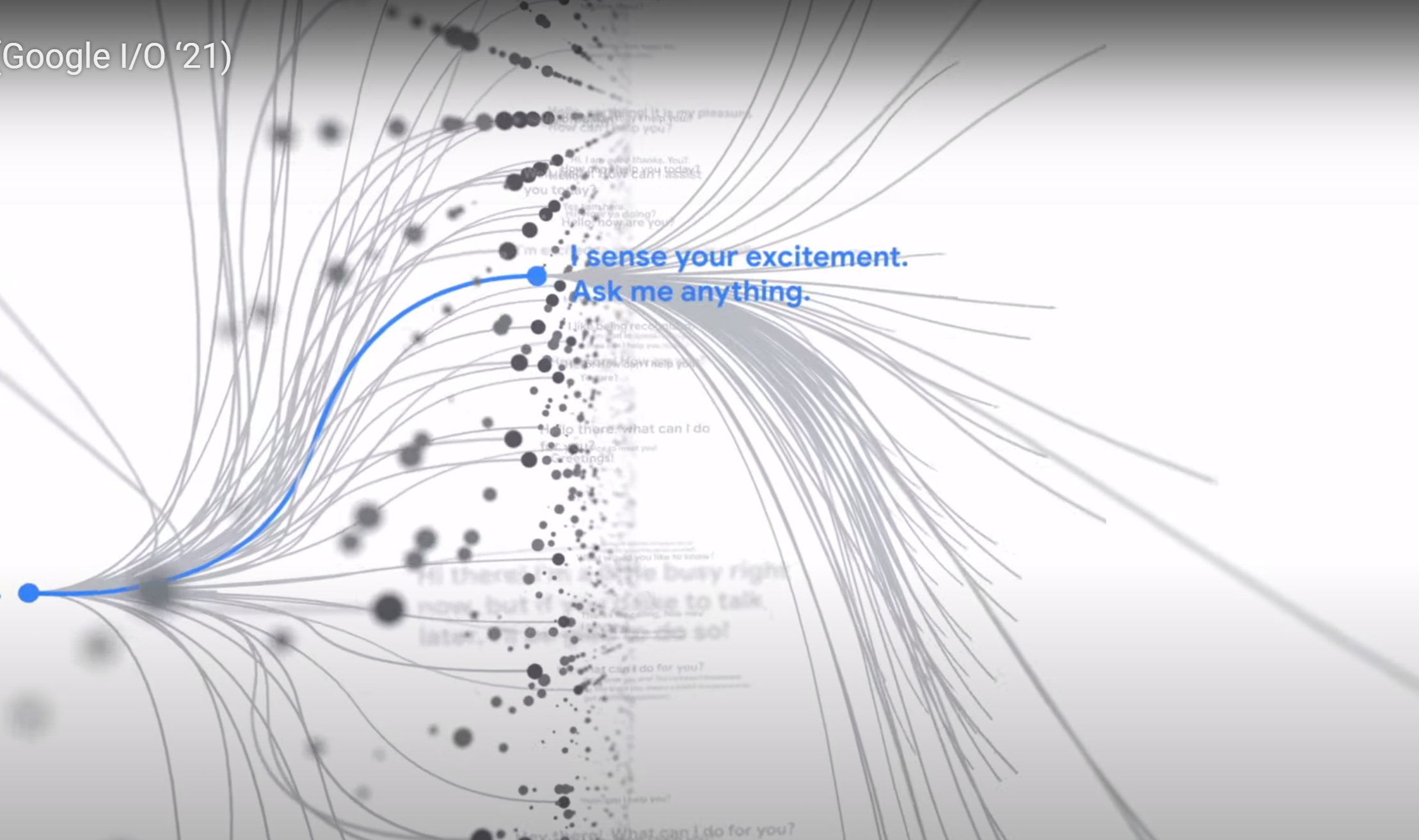

Durch die praktisch unbegrenzten Verzweigungsmöglichkeiten von Knoten im Modell sind komplett offene Gespräche ohne Limits und zu jedem denkbaren Thema möglich, ohne dass das Modell neu trainiert werden muss.

Um das Sprachmodell in die Suche zu bringen, soll eine Technologie mit dem Namen MUM zum Einsatz kommen. Diese steht für Multitask Unified Model und soll laut Google 1000mal leistungsfähiger sein als BERT. Dabei soll MUM in der Lage sein, gleichzeitig sogenanntes Deep World Knowledge anzuwenden, also Wissenskonzepte, sowie verschiedene Sprachen auszugeben und zu lernen und dies auch noch für verschiedene Medien wie Text, Bilder und Videos.

Dabei kann MUM Informationen aus verschiedenen Sprachen und aus verschiedenen Medien zusammenführen. MUM ist auf 75 verschiedene Sprachen trainiert. Und MUM kann nicht nur Sprache verstehen, sondern auch Sprache erzeugen. Google schreibt dazu:

"MUM not only understands language, but also generates it. It’s trained across 75 different languages and many different tasks at once, allowing it to develop a more comprehensive understanding of information and world knowledge than previous models. And MUM is multimodal, so it understands information across text and images and, in the future, can expand to more modalities like video and audio."

Für die Suche könnte all das bedeuten, dass Google Suchanfragen und die Inhalte von Websites sowie die dort verwendeten Medien noch besser verstehen kann. Und: Informationen können zukünftig über Sprachgrenzen hinweg gesucht werden. Gibt es zum Beispiel zu einer Frage, die auf Deutsch gestellt wurde, hilfreiche Informationen auf einer japanischen Website, dann kann MUM diese Informationen erkennen und in deutscher Sprache zur Verfügung stellen.

Welche konkreten Auswirkungen dies auf die Darstellung der Suchergebnisse haben und welche Möglichkeiten zur Optimierung für Websites es geben wird, ist aber noch unklar. Es zeichnet sich aber ab, dass Sprachgrenzen zunehmend verschwimmen werden - und dass Google mit der inhaltlichen Zusammenführung und Aufbereitung der Inhalte noch mehr als Informationsmittler zwischen den Websites und den Nutzern der Suche agiere wird.

SEO-Newsletter bestellen

Verwandte Beiträge

Google Search Live jetzt für einige Nutzer verfügbar