Google Forscher: Chatbots als reine Sprachinterfaces verwenden, Wissen kommt von woanders

Ein bei Google beschäftigter Forscher hat erklärt, wie der Einsatz von Large Language Models mit einer hohen Ergebnisqualität kombiniert werden kann. Dabei soll die Rolle des Sprachmodells auf den Dialog mit den Nutzern beschränkt bleiben.

Bei aller Begeisterung über ChatGPT und ähnliche Chatbots darf eines nicht vergessen werden: Die Qualität der Ergebnisse lässt häufig zu wünschen übrig. Neben falschen Informationen werden auch tendenziöse oder Minderheiten diskriminierende Antworten gegeben. Das liegt an den Informationen, mit denen das verwendete Sprachmodell trainiert wurde. Sind diese Informationen falsch oder anstößig, sind es die vom Chatbot gegebenen Antworten ebenfalls.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

Bei DeepMind, einer Tochtergesellschaft von Googles Mutterkonzern Alphabet, arbeitet man gerade an einem Chatbot, der diese Probleme vermeiden oder zumindest mindern soll. Sein Name: Sparrow. Allerdings ist in diesem Jahr allenfalls mit einer Private Beta des Chatbots zu rechnen.

Google will außerdem noch in diesem Jahr eine Version der Suche mit Chatbot-Funktionalität auf den Markt bringen. Dabei könnte Google eine Aufgabenteilung verwenden, welche die Kommunikationsfähigkeiten eines modernen Chatbots mit der Ergebnisqualität der Suche von Google verbindet.

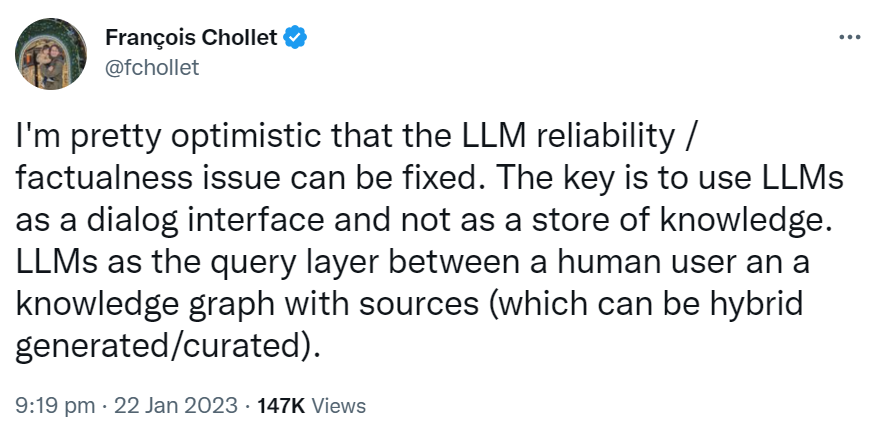

Dass es sich dabei um das Erfolgsmodell der Zukunft handeln könnte, lässt François Chollet anklingen, Softwareentwickler und Forscher für KI bei Google. Er entwickelte unter anderem Keras, eine Open-Source Softwarebibliothek, die ein Python-Interface für künstliche neuronale Netze bereitstellt.

Auf Twitter schreibt Chollet, er sei optimistisch, dass das Problem mit der Zuverlässigkeit und der Sachlichkeit bei Large Language Models (LLM) gelöst werden könne. Der Schlüssel dazu sei, LLM lediglich als Dialoginterface und nicht als Wissensspeicher zu verwenden. LLM werde dann als die Anfrageschicht zwischen dem menschlichen Nutzer und einem Knowledge Graph verwendet, der verschiedene Quellen habe, die hybrid erzeugt und kuratiert werden könnten:

I'm pretty optimistic that the LLM reliability / factualness issue can be fixed. The key is to use LLMs as a dialog interface and not as a store of knowledge. LLMs as the query layer between a human user an a knowledge graph with sources (which can be hybrid generated/curated).

Damit könnte Google seine Vorteile gegenüber der Konkurrenz weiterhin ausspielen: Die Qualität der Suchergebnisse ist es ja letztendlich, die von den Nutzern geschätzt wird und die Google zu seiner Vormachtstellung unter den Suchmaschinen verholfen hat. Kann Google diese kombinieren mit einem überzeugenden Interface, das die Ergebnisse im Stile eines hochentwickelten Chatbots übermittelt, wird es für die Mitbewerber schwer, etwas Vergleichbares zu entwickeln. Aber der Wettlauf um die beste Lösung hat ja gerade erst begonnen - es wird spannend.

SEO-Newsletter bestellen

Verwandte Beiträge

ChatGPT zeigt seit GPT-5.3 keine Query-Fanouts mehr an - doch es gibt eine Alternative